A級順位戦最終日、一敗同率首位の永瀬拓矢九段と糸谷哲郎八段は二人ともそれぞれ佐藤天彦九段、近藤誠也八段に敗れ、プレーオフとなった。

{02/01/2026: [将棋]将棋戦国時代の始まり?}←の予感がさらに強まる。藤井聡太竜王・名人の勝率も今年度は0.766と8割を切っている。

さっき見た人の後ろ姿だと思ったら、また見た人が出てきた。確認するとライブが切れている。映像が繰り返されている。

昨晩は雨のナイトウォークだった。夜中もずっと雨の音がして今朝も降り続いていた。昼前、今は止んでいる。天気予報とGemini3の話を総合すると、南半球で雲が発達しており、その上昇気流が北緯30度付近で下降気流となり(ハドレ−循環)、高気圧を強める。南高北低の夏の気圧配置になっているらしい。偏西風の蛇行の影響が大きいらしい。

| 地域 | 偏西風の状態 | 気温への影響 |

|---|---|---|

| 米国東海岸 | 南へ大きく蛇行(谷) | 北極の寒気が直撃(大寒波・吹雪) |

| 日本(広島) | 北へ大きく蛇行(山) | 南の暖気が流入(5月並みの暖かさ) |

| 時期 | 予測される体感・状況 |

|---|---|

| 〜2月末 | 引き続き非常に暖かい(コート不要な日も) |

| 3月上旬 | 「寒の戻り」あり。 一時的に冬の厚手の服が必要 |

| 3月中旬〜 | 安定して暖かくなり、一気に春本番へ |

今晩のナイトウォークから帰宅して、他にもいろいろと見ていると、おそらく日付時刻や場所によって随分違う。

- NY市閉鎖 | ニューヨーク暴風雪2日目 | 歩行困難 Yuco NEW YORK チャンネル登録者数 3.11万人 2026/02/24 #タイムズスクエア #吹雪 #暴風雪

- U.S. East coast digs out from record-breaking blizzard NBC News チャンネル登録者数 1180万人 408,859回視聴 2026/02/24

- Blizzards slams the Northeast with intense snowfall and high winds NBC News チャンネル登録者数 1180万人 201,995回視聴 2026/02/23

- [4K] NYC Blizzard of 2026 Biggest SNOWSTORM in New York City | Feb 2026 New Walker チャンネル登録者数 4.24万人 13,707回視聴 2026/02/24

- New England Hasn’t Seen a Blizzard Like This in 50 Years Jonathan Petramala チャンネル登録者数 19.3万人 51,012回視聴 2026/02/24 MASSACHUSETTS

AIクロードに「魂」吹き込む哲学者 どのような人物か。さもありなん。Amanda Askell - Google Scholarによれば、Amanda Askellは{Language models are few-shot learners:------→}の著者の一人だ。Pareto Principles in Infinite Ethics | Amanda Askell。

Gemini3と話した。Claudeの憲法とは。

まとめ:知性とは「予測の副産物」か?

現在、多くの研究者が合意しつつあるのは、**「完璧な予測には、世界の真の理解が必要である」**という点です。

「次の単語を100%の精度で当てるためには、その文章が書かれた背景にある物理法則、人間の心理、歴史的文脈のすべてを再現(シミュレート)できなければならない。したがって、予測精度を高める行為は、必然的に知性の構築と同義になる。」

この「予測」と「理解」がコインの表裏であるという視点は、アマンダ・アスケル氏のような哲学者がAIの振る舞いを「憲法」で制御しようとする試みとも深く結びついています。

・・・・・・

結論としての意義

この論文は、**「宇宙全体が無限であっても、私たちの有限な善行には確かな道徳的価値がある」**ことを論理的に救い出そうとする試みです。

アスケル氏が現在Anthropicで取り組んでいる「AIに憲法(原則)を教える」という仕事も、こうした「どのような状況下でも普遍的に適用できる論理的・倫理的ルールを定義する」という彼女の哲学的な専門性が基盤となっています。

・・・

(私) 「次の単語を100%の精度で当てるためには、その文章が書かれた背景にある物理法則、人間の心理、歴史的文脈のすべてを再現(シミュレート)できなければならない。したがって、予測精度を高める行為は、必然的に知性の構築と同義になる。」を主張している論文を教えてください。

あなたが引用されたそのロジックは、現代のAI研究における**「圧縮=理解(Compression is Understanding)」**というパラダイムを象徴する考え方です。

特定のひとつの論文がこの一字一句を述べているわけではありませんが、この主張の**科学的・理論的根拠**となっている重要な論文や言説がいくつかあります。

---

### 1. Ilya Sutskeverの「次単語予測」哲学

OpenAIの元チーフサイエンティストである**イリヤ・サツケヴァー(Ilya Sutskever)**氏は、まさにこのロジックの最大の提唱者です。彼はインタビューや講演で繰り返しこう述べています。

> 「次のトークンを予測するということは、それを生成した『世界』のプロセスを理解することに他ならない。ニュース記事の次の単語を予測するには、政治を理解していなければならず、物理の教科書の次の単語を予測するには、物理を理解していなければならない。」

彼のこの思想の背景にあるのは、以下の理論的枠組みです。

### 2. Marcus Hutter の「Hutter Prize」と圧縮理論

知性と予測(圧縮)を直接結びつけた最も基礎的な理論は、**マーカス・フッター(Marcus Hutter)**によるものです。

* **理論的根拠:** 「データ(テキスト)を限界まで圧縮できる能力は、そのデータに含まれるパターン(=世界の法則)を抽出する能力と同じである」という主張です。

* **関連概念:** **ソロモノフの誘導推論(Solomonoff Induction)**。これは「最短のプログラム(=最も圧縮されたモデル)こそが、最も正確な予測を生む」という数学的理論です。

### 3. "Language Models are Few-Shot Learners" (GPT-3 論文)←------

OpenAIが2020年に発表したこの論文は、スケーリングによって「知性」が創発することを実証した金字塔です。

* **内容:** モデルを巨大化し、次単語予測の精度(Loss)を下げていくと、教えていないはずの「翻訳」「計算」「推論」といった能力が勝手に現れることを示しました。

* **示唆:** 予測精度を高めるという単純な目的関数が、結果として汎用的な知性を構築してしまったことを証明しています。

### 4. "Learning to Simulate the Design of the World" (MIT/Harvardなどの研究潮流)

最近では、LLMを「単なる統計モデル」ではなく**「世界シミュレーター」**と捉える論文が増えています。

* **思想:** 物理的な記述を含むテキストを完璧に予測しようとすれば、モデルの内部に「物理エンジンのような表現」が構築されなければ損失関数を最小化できない、という議論です。

---

### まとめ:どの論文を読めばいいか

もし、この主張の**「核心」**に触れたいのであれば、以下の2つをチェックすることをお勧めします。

- **Marcus Hutter, *"Universal Artificial Intelligence"*:** 知性と予測・圧縮を数学的に結びつけたバイブルです

- **Ilya Sutskever のインタビュー動画(Stanford講義など):** 論文ではありませんが、彼が「なぜ次単語予測が知性に至るのか」を最も情熱的かつ論理的に語っています。

アマンダ・アスケル氏のような哲学者が関心を持っているのも、この**「統計的な予測の先に、なぜか『意味』や『倫理』を理解する心が(計算上)必要になってしまう」**という不思議な逆転現象だと言えます。

松田語録:ストールマンのLLM批判 SingularitySalon チャンネル登録者数 1.18万人 2,905回視聴 2026/02/22 収録日:2026年2月19日を最近視聴した。FSFのRichard Stallmanが何を言っているのか興味深かった。しかし、いずれにせよ、凄いことが起きていることは間違いない。Next Word Predictionから知性が生まれている。ある意味、Scaling則は、情報が圧縮され、予測精度が高くなるということは、世界モデルが出現することと等価という話らしい。

ようやく配信も2月分に入った。

https://youtu.be/T3JsbvvWuwo 00:00 (出発) さあ、行きます。・・・・・・今日は晴れてますね。もうすぐ日が沈みます。(南区役所前交差点に向う) 00:56 渡り鳥が飛んでますね。渡り鳥が・・・あーれ・・・あれは鵜みたいだけど。(京橋川上空を雁の群れがいくつか渡っていった後、鵜が一羽追い掛けている。画面には鵜が見えている) 01:11 (国道二号線を渡る) 01:51 (南区役所前交差点、皆実線横断待ち) 02:31 図書館帰りの道草日記の174回です。 03:34 ただいまの時刻17時21分55秒。(京橋川平野橋東詰到達) 03:54 さあ・・・今日は引いてますね。 04:28 いましたね。ちょっと波でよく見えませんけどね。 05:33 さあ、・・・・・・さて、・・・あー、・・・西岸の方にはカモメでしょうね。 06:32 今日は来る時に渡り鳥が雁の群れでしょうね。ずっと飛んでいってましたね。 06:42 飛行機が・・・・・・たくさん飛んでます。(UFO的飛行雲飛行) 07:52 さあ、第1船着き場。 08:56 (鳥、雁かな、上空を飛んでいく。第一ベンチに人がいるので黙って通り過ぎる) 09:59 夾竹桃ですね。 10:04 さあ、今日も少し遅かったですね。来るのが。ちょっと寒いです。 10:15 カモメですね。 10:32 さあ、第2船着き場です。 10:49 第一ベンチは人がいたので。(犬の鳴き声) 犬が鳴いてましたね。 11:21 カラスが干潟を歩いてます。もう少し近づいて。 11:41 第二ヤマモモですね。 12:08 カラス。カラスくん。寒い中、頑張って。 12:38 さあ、サルスベリですね。(前進) 13:17 さあ、これはどうなるんだ。(新しく植えられたものを観察する) 13:45 鳴いてますね。カモメが鳴いた。 14:01 こちらにも何かいるのかな。 14:05 これは何だろう。 14:07 鳥じゃない。あれは何か。 14:21 さあ、第3ベンチ。(言い間違い) 14:23 第3船着き場ですね。 15:02 カモメがいますね。 16:18 もう1羽いたね。 16:38 これ今、先ほどと一緒です。 17:21 2羽が集まりました。 17:32 ハクセキレイですね。 17:34 ああ、2羽いた。 18:00 さあ、第4ですね。第4船着き場。 18:08 今、飛んでたのにね。 18:23 カモメですね。 18:25 今、2羽いた。1羽が飛んだんです。 18:38 あー、水の中にもいましたね。 18:48 飛んで来ました、飛んできました。 18:58 鳴いていますね。 19:22 何か向こうに水鳥がいますね。 19:26 第2ベンチ到達ですね。 19:36 ちょっともう寒いから、今日は。 19:43 一人読書会を。 19:45 今日、借りたのは龍と苺の。 19:47 20巻だったか21巻だったか。 19:49 なので、 19:51 1冊だけなんで。 19:55 3羽ですね。 21:03 鳴き方は、カモメの鳴き方だったけど。 22:06 これですね。 22:12 ちょっとカモメにしては痩せてるような感じに。 22:14 ちょっと見づらい。 22:21 ツバキ、第一ツバキですね。 24:03 メシベが、 24:09 こう、まとまって、 24:11 まだツバキですね。 24:15 前も言いましたけど。 24:29 みんな飛んできてますね。 24:37 だんだん下流の方に、 24:44 カモメが飛んでいってます。 24:53 さあ、第6ですね。 24:55 第6船着き場。 25:09 さあ、今日はこれぐらいですからね。 25:12 ハクセキレイはね、 25:17 うまく捉えたいんですけどね。 25:20 なかなかね、 25:24 ハクセキレイはね、 25:29 敏感で。 26:08 さあ、第二ツバキ。 26:19 まだ咲かないですね。 26:24 ハナミズキもまだ、こうやって実が残ってるんですね。 26:33 赤い葉が、 26:38 ずーっと出てますよね。 26:42 なんですかね、これ。 26:46 さあ、第3ツバキ。 26:51 赤い花が、 26:59 前、撮ったやつかな。 27:27 第三ヤマモモですね。 27:50 帰って行っちゃった。 27:52 カモメたちも。 27:56 おそらく帰ったんじゃないかな。 27:58 あ、あ、鵜だな、あれは。 28:00 行っちゃいましたね。 28:12 御幸橋の向こうに。 28:26 イソヒヨドリですかね。 29:14 まあ、こんなところで。 30:09 はい、逃げませんね。 30:16 (イソヒヨドリ) 電池が60%になって、 31:22 電池を付け替えました。(ワイヤレス充電池を付けて、イソヒヨドリをさらに継続して観察) 32:31 次々に御幸橋、ヒロデンが、 32:49 電車きてますね。 33:41 (イソヒヨドリ) まだいるね。 33:45 終わりにしましょう。 33:48 さっき途切れた、 33:52 龍と苺の話は、 33:54 100年後の世界を描いてるんですね。 33:56 話題になってるんですけどね。 34:08 まあ、これぐらいにしておきましょう。 34:10 ヒロデンが・・・ 35:21 (鳥が上空を飛んでいく) あー、渡り鳥が。暗く (咳) 失礼 35:57 失礼。 35:59 暗くなったら、 36:01 いないですね。 36:04 さあ、第8に来ましたね。 36:06 これぐらいで、 36:26 ヒロデンで終了しましょうか。 37:03 第5ナンキンハゼですね。 37:20 じゃあ、 37:23 お疲れ様でした。 37:25 いつもご視聴ありがとうございます。 37:27 終了しまーす。

#13 理論で知能を捉えるとはどういうことか(ゲスト:磯村拓哉さん)|記号創発クロストーク TANICHU NEVER KNOWS (Tadahiro Taniguchi) チャンネル登録者数 466人 道草 538 回視聴 2026/02/18 記号創発クロストーク。A01 磯村拓哉 - 予測と行動の統一理論の開拓と検証。この逆、動画のカメラワークから、字幕の発声と合わせて、意味的なシーンの切り替えを抽出できないか考える。

【日本のロボットは“100点主義”を捨てよう】「強い現場データ」を生かせ/フィジカルAIの“脳”は米国で驚きの進化/中国は2兆円投資「本気の国策」で量産/ベンチャー投資家・頼嘉満【1on1 Tech】 TBS CROSS DIG with Bloomberg チャンネル登録者数 59万人 9,129 回視聴 2026/02/22。空間知能は道草で研究できるのでは。フェイフェイ・リー氏のWorld Labsが10億ドル調達、「空間知能」構築へ──CAD大手のAutodeskは2億ドル投資、3D世界モデル「Marble」推進 | Ledge.ai。Gemini3との対話には、既にVLM(Vision Language Model)関連のPythonライブラリ名が出てきている。Vision Language Model の 技術詳細と推論と学習|npaka。

| 日付 | 道草 | 散歩世界 | ナイトウォーク | イブニングウォーク | デイウォーク | 備考 |

|---|---|---|---|---|---|---|

| 2026-01-20 | 172 ({02/14/2026: [日記]道草172前編}{02/15/2026: [日記]道草172後編}←) | - | - | - | - | {01/22/2026: [日記]道草・散歩世界・ナイトウォーク・ナイトスケッチの整理ノート}← |

| 2026-01-22 | - | 60 | - | 1 | - | - |

| 2026-01-23 | - | 61 | 24 | - | - | - |

| 2026-01-26 | - | 62 {02/18/2026: [日記]散歩世界62、ナイトウォーク25 - 九つのナイトスケッチ}← | 25 | - | - | - |

| 2026-01-28 | 173 ({02/19/2026: [日記]道草173前編で「鳥出現」マーク}{02/21/2026: [日記]道草173 - 動画の文脈を辿る}←) | - | - | - | - | - |

| 2026-01-29 | - | 63 | 26 | - | - | - |

| 2026-01-30 | - | 84 | - | 2 | - | - |

| 2026-02-02 | - | 65 | 27 | - | - | - |

| 2026-02-03 | 174 | - | - | - | - | - |

| 2026-02-06 | 175 | - | - | - | - | - |

| 2026-02-08 | 176 | - | - | - | - | 大雪、参院選、棋王戦第一局、{02/08/2026: [日記]文学フリマ広島8、道草176の帰り道 - 南天や 雪の重みに 撓みけり}← |

| 2026-02-09 | - | 66 | 28 | - | - | - |

| 2026-02-11 | 177 | - | - | - | - | {02/12/2026: [日記]昨年の今頃 - 道草91の野鳥たち}← |

| 2026-02-13 | - | 67 | 29 | - | - | - |

| 2026-02-14 | 178 | - | - | - | - | {02/18/2026: [日記]道草の哲学 - 日々過ぎ去り、バレンタインの日も過ぎた}← |

| 2026-02-15 | - | 68 | 30 | - | - | - |

| 2026-02-16 | - | 69 | 31 | - | - | - |

| 2026-02-17 | 179 | - | - | - | - | - |

| 2026-02-20 | - | 70 | - | - | 1 | - |

| 2026-02-21 | 180 | - | - | - | - | - |

| 2026-02-22 | - | 71 | - | - | - | 陶芸サークル「陶親会」訪問 |

{02/19/2026: [日記]道草173で「鳥出現」マーク}←に続いて、後編も配信した。カラー・チャプターをまとめておこう。

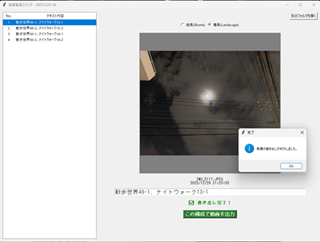

道草172ぐらいから、脚本も何もない自然動画ならではの動画の文脈を辿ってショート動画配信を構成する方法を体得しつつある。NotebookLM/Gemini3を使って動画を分節化する方法をいろいろ試して配信してみたものの満足のいくものにはならなかった。Gemini3との対話から、Subtitle Editで字幕のColorを使えば、字幕-動画の分節化が表現でき、ショート動画の切り出しが自動化できる有用な方法になることがわかってきた。

Gemini3との対話を継続して、YOLOとBioCLIPの二段階処理で、鳥の出現の検出(YOLO)からBioCLIP(BioCLIP: A Vision Foundation Model for the Tree of Life)で映像を切り出し、種を判定するという方法も試しているが、完璧にはならない。鳥は見ればわかるので、種がわからなければGemini3にスクリーンショットで尋ねるという方法で十分だ。結局、動画の文脈を自ら捉える過程ですべては完了する。自動化はfaster-whisperによる字幕の基礎データの作成、動画を字幕行のカラー化に基づいて切り出すぐらい。動画の文脈を辿る過程で、faster-whisperの字幕も聴き取りが抜けている箇所がないわけではないということに気付く。自分の聴き取りに基づいて字幕を作成挿入し動画の文脈を完成させている。

https://youtu.be/u-uE8nYFjqY 00:00 行きましょう。 00:02 今日は内蔵マイクです。 00:04 渡りましょう。 00:43 今日は図書館帰りの道草日記の173回です。 03:08 さて、平野橋下に到着です。 03:12 今日は澄んでますね。 03:16 でも魚はいませんね。 03:46 ハクセキレイですかねえ? 04:16 尻尾が長いですね。 04:17 何だろう。 05:02 さあ、もう少し近づけよう。 05:32 毛づくろいで忙しくて、こちらに気が付いてないもんね。 06:43 これくらい撮れたら 06:51 わかりますね、何か。 07:27 さあ、行きましょうか。 07:40 逃げませんねえ。 07:59 丸々と太ってますね。 09:07 よく澄んでるね。 09:20 1、2、3、4、4段目ですね。 09:26 5、6、7、8段目まで見えてるから。 09:30 5、6、7、8段目がかすかに見えてますね。 09:43 1、2、3、4、5、6、7、下りてみましょうかね。 10:27 こんなに綺麗なの見たのは初めてかなあ。 11:23 さあ、第一ベンチ到達ですね。 11:31 夾竹桃もさすがに。 11:57 つぼみもないですね。 12:02 一応真冬ですもんね。 12:10 ハナミズキはまだ実がちょっと残ってますね。 12:28 これはナンキンハゼですね。 12:31 さあ、第二船着き場ですね。 13:43 ただいまの時刻17時03分45秒ですね。 13:47 さあ、第二ヤマモモですね。 14:16 さあ、サルスベリです。 14:27 ハナミズキ。 14:30 タブノキ。 14:31 ハナミズキ。 14:36 クスノキ。 14:37 さくらですね。 14:39 さくらの芽ですね。 14:59 あれ、ここ何か植えてあるね。 15:01 これ何だろう。 15:07 ここは第三船着き場です。 15:22 鳥が行ってるね。 16:10 下行って撮ってみましょう。 17:06 (犬か鳥の鳴き声?) 犬の鳴き声が西岸から聞こえました。 17:32 (風と波の音) 波の音が入りましたかね。 19:09 第4(船着き場)ですね。 21:35 さあ、第五(船着き場)ですね。 21:36 第二ベンチはいつも歩いてられる方が休まれている。 21:57 あ、寒いな。 21:58 7度まで下がってますね。 22:07 10度だったからいいなと思いながら出たんですけど。 22:40 それでは一旦休止しましょう。

https://youtu.be/RNh4bVhgvLk 02:17 レイ・ダリオという人の、世界秩序の変化に対処するための原則、なぜ国家は興亡するのか、これを今日は借りてきたので、一冊返して、一冊借りまして、借りてきました。 02:43 日本経済新聞の出版から出てますね。 02:47 これ最近、YouTubeなんかでもこの人のことが話題になってて、 02:54 それで興味を持って、伝説的投資家で、世界的ベストセラー「プリンシプルズ」の著者レイ・ダリオは、 03:13 半世紀以上をかけて、世界各国の経済とマーケットを調べてきたと。 03:19 その彼が過去500年に起きた政治的経済的の激変を研究して、現在に生きる人々が経験したことのない、 03:28 根本的変化が将来発生しうることを解説すると。 03:35 そういうふうなことですね。 03:39 うーん・・・何が書いてあるんでしょう。まあそういうことで、今日はこの一冊ですね。 03:49 まあまた、中身で関心があれば、また何か言うかもしれません。 04:00 まあ一応これで、一人読書会を終わってですね。 04:07 今17時17分、17秒です。 04:13 さあ、行きましょう。 05:37 これは(第一)ツバキ。つぼみ、つぼみ、花粉、めしべというか、おしべというか、 05:57 これがまとまっているのが椿で、あれが広がっているのがサザンカなんですね。 06:06 さて、第六ですね。第六船着き場に来ました。 06:25 (京橋川西岸、川面の流れ) 06:44 これですね。夜、ナイトウォークで見えているビルは、これが光っているんです。 07:02 寒いから帰りましょう。 08:01 さあ、謎の物体は、 08:12 そうですね。やはり何かセンサーかな。 08:14 何かが浮かんでいるんでしょうね、あれ。 08:33 手が悴んできました。カメラを持つのはね、素手でないと。 08:46 たくさん、花が咲きそうです。 08:49 第二椿です。 09:03 (ハナミズキ) 少しまだ、赤い実が残っています。 09:15 さあ、第三椿。 09:27 もう咲いたのかな。めしべ、おしべ。 09:29 まとまっていますね。 09:45 (風音、京橋川西岸風景) 09:54 ( 京橋川西岸風景)さあさあ・・・そろそろ・・・(大風切り音) 10:16 (大風切り音)第七船着き場到着です。(日没) 10:32 魚がいましたね、今 (水面に円形の波立ち) 跳ねましたね、音が入りましたかね。 10:57 (御幸橋ヒロデン) 11:18 さあ、行きましょう。寒いや! 11:33 もっと着込んでくれればよかった。 11:48 8度になっているのに、体感、2度くらい高いんだろうね。 13:18 さて、第八の船着き場です。 13:24 ハクセキレイだった。 13:40 指が入っちゃった。 13:47 惜しかったねえ。 14:08 それでは、終わりにしましょう。 14:10 第四ベンチです。 14:17 ヒロデンも来てます。 14:58 夕日が見えましたね。 15:00 これで、終わりにしましょう。 15:06 夕日が沈んじゃいました。 15:24 みんなよく通ってくれた。終わります。お疲れさまでした。いつもご視聴ありがとうございます。買い物に行って帰ります。

トランプ大統領の経済政策は日本に大チャンス!?中間選挙を前に始まる“アメ”政策 アメリカ 中国 世界の経済はどうなる!【齋藤ジン】「池上彰がいま話を聞きたい30人」 テレ東BIZ ダイジェスト チャンネル登録者数 254万人 150,327 回視聴 2026/02/10 テレ東BIZオリジナル(番組)と高市政権の高圧経済は危険!?短期的には株高だが中長期的には大損失?世界の投資家が抱く日本経済への懸念とは【齋藤ジン】「池上彰がいま話を聞きたい30人」 テレ東BIZ ダイジェスト チャンネル登録者数 254万人 58,463 回視聴 2026/02/17 テレ東BIZオリジナル(番組)。Jin Saito - Observatory Group。

【ChatGPTにエクセル仕事は無理】Claudeの“記憶力”が向上「正直なんでもできる」今井翔太/アンソロピックはシビアな性能レースを強いられる/一点突破でGoogleも置き去り【AI QUEST】 TBS CROSS DIG with Bloomberg チャンネル登録者数 58.5万人 63,539 回視聴 2026/02/19にも出てくる。ダリオ・アモデイが言ったらしい。ダリオ・アモデイ - Wikipedia。

鳥が出現した経過時間位置にマークを入れる。

https://youtu.be/u-uE8nYFjqY 00:00 行きましょう。 00:02 今日は内蔵マイクです。 00:04 渡りました。 00:43 今日は図書館帰りの道草日記の173回です。 03:08 さて、平野橋下に到着です。 03:12 今日は澄んでますね。 03:16 でも魚はいませんね。 03:30 ハクセキレイですかねえ? 03:47 (鳥出現) 03:50 (鳥出現) 03:51 (鳥出現) 04:11 (鳥出現) 04:14 (鳥出現) 04:16 尻尾が長いですね。 04:17 (鳥出現) 04:20 何だろう。 04:24 (鳥出現) 04:25 (鳥出現) 04:26 (鳥出現) 04:27 (鳥出現) 04:31 (鳥出現) 04:32 (鳥出現) 04:38 (鳥出現) 04:39 (鳥出現) 04:49 (鳥出現) 04:52 (鳥出現) 04:57 (鳥出現) 05:05 もう少し近づけよう。 05:12 (鳥出現) 05:26 (鳥出現) 05:31 (鳥出現) 05:32 毛づくろいで忙しくて、こちらに気が付いてないもんね。 05:40 (鳥出現) 05:49 (鳥出現) 05:50 (鳥出現) 05:53 (鳥出現) 05:54 (鳥出現) 05:56 (鳥出現) 05:59 (鳥出現) 06:02 (鳥出現) 06:05 (鳥出現) 06:06 (鳥出現) 06:07 (鳥出現) 06:08 (鳥出現) 06:09 (鳥出現) 06:11 (鳥出現) 06:12 (鳥出現) 06:14 (鳥出現) 06:16 (鳥出現) 06:18 (鳥出現) 06:19 (鳥出現) 06:21 (鳥出現) 06:24 (鳥出現) 06:25 (鳥出現) 06:29 (鳥出現) 06:30 (鳥出現) 06:33 (鳥出現) 06:35 (鳥出現) 06:37 (鳥出現) 06:43 これくらい撮れたら 06:44 (鳥出現) 06:46 (鳥出現) 06:48 (鳥出現) 06:51 わかりますね、何か。 06:53 (鳥出現) 06:54 (鳥出現) 06:57 (鳥出現) 07:00 (鳥出現) 07:04 (鳥出現) 07:05 (鳥出現) 07:07 (鳥出現) 07:09 (鳥出現) 07:12 (鳥出現) 07:15 (鳥出現) 07:16 (鳥出現) 07:18 (鳥出現) 07:19 (鳥出現) 07:25 (鳥出現) 07:27 さあ、行きましょうか。 07:40 逃げませんねえ。 07:41 (鳥出現) 07:55 (鳥出現) 07:59 丸々と太ってますね。 08:13 (鳥出現) 08:19 (鳥出現) 09:09 さあ、行きましょうか。 09:11 よく澄んでるね。 09:13 1、2、3、4、4段目ですね。 09:19 (鳥出現) 09:26 5、6、7、8段目まで見えてるから。 09:30 5、6、7、8段目がかすかに見えてますね。 09:43 1、2、3、4、5、6、7、下りてみましょうかね。 09:43 (鳥出現) 10:27 こんなに綺麗なの見たのは初めてかな。 11:23 さあ、第一ベンチ到達ですね。 11:31 夾竹桃もさすがに。 11:57 つぼみもないですね。 12:02 一応真冬ですもんね。 12:10 花水木はまだ実がちょっと残ってますね。 12:28 これはナンキンハゼですね。 12:31 さあ、第二船着き場ですね。 13:43 ただいまの時刻17時03分45秒ですね。 13:47 さあ、第二山桃ですね。 14:16 さあ、サルスベリです。 14:27 花水木。 14:30 タブノキ。 14:31 花水木。 14:36 クスノキ。 14:37 さくらですね。 14:39 さくらの芽ですね。 14:59 あれ、ここ何か植えてあるね。 15:01 これ何だろう。 15:07 ここは第三船着き場です。 15:22 鳥が行ってるね。 16:10 下行って撮ってみましょう。 16:57 鳴き声が西岸から聞こえました。 17:42 入りましたかね。 19:09 第4(船着き場)ですね。 20:00 (鳥出現) 21:35 さあ、第五(船着き場)ですね。 21:36 第二ベンチはいつも歩いてられる方が休まれている。 21:57 あ、寒いな。 21:58 7度まで下がってますね。 22:07 10度だったからいいなと思いながら出たんですけど。 22:40 それでは一旦休止しましょう。

ようやく配信した。2026-01-26の日記。

https://youtu.be/euBGKPUoN8Y 00:17 さて、ずっと今日は喋りながら、ナイトウォークの買い物メモっていうのを始めようかと、思いつきなんですが、 01:02 今日はですね、これから買い物に行きます。 01:16 卵、牛乳、それから冷凍のほうれん草ですね。 01:24 刻みオクラ、これも冷凍で、それぐらいかな。 01:33 思いついたのはそれぐらいでしたね。 02:06 まあそういうことで、ナイトスケッチを一応終わります。 02:13 あれ、ビデオにしてしまった。 02:18 まあいいか。 02:19 これがいつも道草日記で見ているタワービルですね。 02:26 だけど、京橋川だからすぐ近くなんです、ここは。 02:32 タワービルは西岸にありますからね。 02:35 ただいまの時刻が、19時44分01秒ですね。 03:55 これを自転車が避けて通ってきました。 04:08 向こうが、皆実町6丁目交差点ですね。 05:44 人とすれ違いました。 06:25 ヒロデンが入ってきましたね。 07:01 今、一旦終了。 07:44 行き交いますね。 07:52 買い物を思い出しました。 07:57 豆腐に納豆、あとバナナかな。 08:16 まあそういうことで。

コーヒーの 後に届いた チョコレート まちがい探し のバレンタイン (2026-02-14)。俳句17文字では表現しきれないものもある。短歌31文字も援用しよう。多少の字余りもあるかもだが^^;)朝早く配達があって受け取れなかったチョコレートが道草178の後に届いた。再配達が翌日になったなあと思っていたら、バレンタインを意識したのか、夕方に届けてくれた。道草178ではジェフリー・ディーヴァー著「シャドウ・ストーカー」を借りた。今日(2026-02-17)は道草179、返却期限の一冊、李舜志著「テクノ専制とコモンへの道 民主主義の未来をひらく多元技術PLURALITYとは?」(集英社新書、2025年)を借り直した。一人読書会では、大岡信著「新 折々のうた 1」(岩波新書、1994年)の話も。

- 更新日記記事の「ジェフリー・ディー(ヴァ|バ)ー」検索結果

- [映画]Never Say Never Again (2016/02/17)

- [本]久々の本屋にて (2016/04/10)

- [Music]秋、急に寒くなる - Norah Jonesを聴く (2016/10/11)

- [日記]日曜の朝、静けさの中で - 百年前の意味 (2016/10/23)

- [アート]十夜一冊 第千七百七十夜 原田マハ著「楽園のカンヴァス」 (2019/09/01)

- [日記]夢の中で - 道草165ショート・ストーリー配信 - 「道草」は「roadgrass」か「grass on the wayside」か (2026/01/17)

- 更新日記記事の「PLURALITY」検索結果

- [Perl 6]Jonathan Worthington - Concurrency keynote (2019/08/25)

- [Perl]記憶の細道プロジェクト Perlによる自然観察(事象)マップ再入門 - PLURALITYの刺激 (2025/07/22)

- [A.I.]ChatGPTとの対話 - 道草チャプターと関係スキーマ (2025/08/04)

- [日記]道草は人間とは、生命とは何かを考える旅 - 八月の終りに (2025/08/31)

- [YouTube]PLURALITYの続きだけど、柄谷行人の話も、ベルナール・スティグレールの物語は発展するのか? (2025/11/22)

- 更新日記記事の「大岡信」検索結果の一部

- [司馬遼太郎]空海の風景 上 (2009/10/04)

- [日記]桜、大岡信 (2017/04/05)

- [アート]英国ウェールズ国立美術館所蔵「ターナーからモネへ」展、縮景園の桜、自選「大岡信詩集」 (2017/04/09)

- [日記]言葉と物 2.1 - II. Sign of the Times (2017/04/09)

- [日記]直観 (2017/04/10)

- [詩歌]言葉と物 2.1 - III. 認識以前、名辞以前 (2017/04/15)

- [読書]溢れる本、それでも「ブンガクにもっと光を」 (2017/04/23)

- [アート]日曜美術館「遠藤彰子」 - 海暮れゆけばただ仄かなる (2018/10/14)

- [哲学]抽象と具象 (2021/08/03)

- [読書]十夜一冊 第二千百六十夜 津野海太郎著「読書と日本人」(岩波新書、2016年) (2022/05/29)

配信、軌道に乗る。

https://youtu.be/sMrq1mL78T4 00:12 サイドボタンに触ってしまって止まってしまった。 00:19 鳴いてますね。 00:26 ハクセキレイ。 00:30 ノイズキャンセルをしないようにしてるので、入ってるかもしれませんね、音声が。鳴き声がね。 00:58 羽根を広げましたね、今。カモメなのかな。さあ、 01:23 これはツバキでしょうか。サザンカでしょうか。ツバキでしょうね。だと思ってるんですけど。 02:25 ずっと流れに身をまかしてますね。身をまかしてるというか、川下に流れてるんだけど、一定の位置を保ってますね。 02:46 (強い風音)そう、寒くなってきましたね。第3ベンチも通り過ぎてしまった。ちょっと店を広げる気にならない寒さですね。 03:51 ただいまの時刻が。 03:54 17時16分48秒ですかね。 03:57 そう、またいましたね。 04:11 ああ、行っちゃった。さあ、第3ヤマモモが行きました。 04:51 あれ、ハクセキレイですね。今、ハクセキレイがいましたね。 05:14 (ハクセキレイ)今、二羽がいました。一羽は岩壁から降りましたね。どんどん下に降りてきましたね。 06:09 第7船着き場です。 06:49 (ハクセキレイ)もう一羽来ましたね。 07:05 ああ、 07:06 飛んで行っちゃいました。 07:11 ああ、一緒に飛んで行きましたね。波を打つように飛んで行くんですね。(京橋川西岸へ) 07:57 (日没) 08:17 さて、さて、・・・・(干潟のカラス)・・・終わりにしましょう。 09:25 (風音、干潟のカラス) 09:40 いそしぎです。おそらく。さっきいたやつ。 10:03 (風音、干潟のカラスが飛び立つ) 10:27 (御幸橋ヒロデンが往く) 10:44 さあ、終わりにしましょう。おつかれさまでした。終了しまーす。お疲れ様・・・

【ChatGPTの野望は“全知全能”への進化】今井翔太「いまさらAI開発レースを止められない」/OpenAIは評価額「100兆円」でも大赤字/「人類の利益」より広告でカネ儲け【AI QUEST】 TBS CROSS DIG with Bloomberg チャンネル登録者数 57.3万人 106,851 回視聴 2026/02/13にもOpenClawの話題が出ているので、コーディングに限定して安全な環境を設定するにはという対話をGemini3とDeepSeek V3.2完全版としてみたものの一般的な用途には興味が湧かないし、コーディングにしても本当にそんなことするかなあと、立ち止まっている。まあ、今のところ、開発に困っているわけではないし、興味はあるが、試すのも手間、面倒かな。アイデアが出てくるか困ったら考えよう。

{02/04/2026: [A.I.]Moltbook}←にOpenClawを使うらしい。

さて、2026-01-20の日記:

https://youtu.be/cO-Ag6olCcM 00:02 さあ、行きます。 00:08 日が沈みそうですね。 00:21 西の空は少し青空が出てますけど。 00:31 (皆実線ヒロデンが通る) 00:51 さて、さて、さて、さて。 00:56 どうなりますかね。 00:58 はい、はい。 00:59 ああ、今日は風が強いですね。 01:23 (ヒロデンを見ながら皆実線を渡る)今日は図書館帰りの道草日記の172回です。 03:31 ああ、今日は、引いてますね。 03:58 明日から5日連続で寒気が降りてきて、日本海側は大雪になるという話なので、ちょっと今日は出てこざるを得なかったですね。 04:45 明日は恐らく寒くなるんじゃないかなと思います。 04:50 今日はそんなに寒くないですね。 04:52 さあ、あそこに鳥が一羽見えましたね。 06:00 ああ、飛びましたね。 06:01 カラスか。 06:33 (ハクセキレイ) 07:01 さあ、さあ、寒風の中にいましたね。 07:18 こちらを見たまま、・・・・・・ 07:37 さすがに降りちゃいましたね。 08:04 (平野橋から京橋川西岸風景) 08:33 (イソヒヨドリ) 08:41 イソヒヨドリですかね。 08:41 この黒い、じーっとしてます。 08:57 最初のがイソシギですかね。 10:03 ちょっと、よく分からないですけどね。 10:09 第二船着き場ですね。 10:27 向こうにカモメがいますね。 10:30 西岸に。 10:31 さあ、さあ。 11:42 第3船着き場ですね。 11:44 さあ、第4船着き場です。 13:41 回り込んでみないと、鳥がいたりしますからね。 13:43 ハクセキレイの声のような気がしましたけど、・・・ 14:44 何か泳いでますね。 14:52 もう近くまで行ってみましょう。 15:39 第5船着き場です。

思いを感情を詠む。

土星居り 寂しさ募る 散歩かな (令和七年十一月二十八日)

晴れた夜 月魚座星 灯りかな (令和七年十二月六日)

なをよべど ゆめにこられん あいうえお (令和七年十二月七日)

木星を 見間違えたり 夜散歩 (令和七年十二月九日)

初冬や 流星ながる シリウスに (令和七年十二月十二日)

ふたご座の 流星ながる みぎひだり (令和七年十二月十四日)

悲しみの つぶやき寂し クリスマス (令和七年十二月二十五日)

神無しみに 振り返り見る ジュピター星 (令和七年十二月二十七日)

新年に 気持ちは越せぬ 大晦日 (令和七年十二月三十一日)

寒夜空 下水工事や 音響け (令和八年一月二十三日)

百万遍名を呼ぶかな 冬の夜 (令和八年一月二十六日)

言い残した 言葉に答えん 冬の日々 (令和八年一月二十六日)

残された 君の御膳の 冬見ゆる (令和八年一月二十六日)

南天や 雪の重みに 撓みけり (令和八年二月八日)

動画タイトルは必ずしも内容とは一致していない。せっかくいい番組なのに品位に欠けるように思うがどうか。おそらくLLM生成タイトルかな。「」の片方が欠けている。AI中心のOSとか、ユーザーインターフェースとかという言葉が出ているが、はて、良いような悪いような。

さて、道草177に昨日行ってきた。雁が飛んでいる。昨年の今頃に遡る。

2025-02-06の日記:

https://youtu.be/UqnGxWsGzB0 00:02 さあ、行きます。 00:04 図書館帰りの道草日記の91回。 00:15 一応、図書館から帰ってはいるんですけど、 00:26 今日は本を借りたわけじゃなくて、 00:29 昨日、眼鏡を忘れたと思ったので、探しに来たんです。 00:37 見つかりませんでした。 01:09 どこで忘れたのかな。 01:11 まあ、仕方がないので、道草をして帰ります。 02:20 家で、家のどこかで、置き忘れたのかな。 02:24 いや、そんなはずはない。 02:28 帰る途中で気がついたので、 02:38 この道草の途中で、どこかで、眼鏡を外したかな。 02:51 いや、透明ですね。 02:54 透明ですけど、魚はいないですね。 03:09 今日は引いてますね。 04:03 まあ、今日も水温を測りました。 04:08 ああ、よく澄んでるな。 04:28 1、2、3、4、5段目が浸かってますね。 04:32 5、6、7、8、9、9まで全部見えてますね。 04:38 この上から。 04:46 1、2、1、2、3、4、1、2、3、4、5、6、7、8、9。 05:01 数えられますよね。 05:05 さあ、こんなに澄んでいるのは珍しいですね。 05:09 九段全部見えますね。 05:17 それでは、放射温度計で測りましょうね。 05:23 えっと、1、2、3、4、おっとっとっと。 05:34 あぶない。 05:35 やはりね、ぬるっとしてるんですよね。 05:52 7.6度ですね。 05:54 今日は高いですね。 05:56 石畳が9.0度。 06:06 ああ、今日、最高気温3度とか言ってなかったかな。 06:13 そんなに、そんなに寒い感じはないですね。 06:30 さて、まあ、今日は第一ベンチ到達ですね。 06:54 ああ、山が見えてますよね、今日はね。 06:57 駅方面。 07:06 完全に昨日は曇ってる。 07:08 おお、鳩だな。 07:11 鳩が飛んでいきますね。 07:13 明日、明後日が雪の低温で、雪の可能性があるっていうのと、天気予報では言ってますよね。 07:56 さあ、さあ、第二船着き場を越えましたね。 08:25 シナノツツジ。 08:47 昨日はね、雪が少しは、雪化粧。 08:54 かすかな雪化粧をしてたんですけど。 08:59 昨日は雪化粧という言葉は思いつかなかった。 09:10 雪化粧っていう言葉になっちゃったんですけど。 09:16 ああ、鳥いますね。 09:18 ああ、もういないわ。 09:34 あれあれ。 09:41 ああ、飛んできますね。 09:43 あれはイソシギのような感じだな。 09:46 ハクセキレイじゃなかったですね。 09:56 第三船着き場です。 10:16 この付近にいましたね。 10:24 ああ、昨日と同じボートが。 10:34 昨日と同じボートのような気がしますね、これは。 10:51 定期船ですね、おそらく。 11:54 こういう風に波が押し寄せてきます。 12:17 いましたね、ハクセキレイのような感じだな。 12:21 昨日と一緒かな。 12:30 自転車が通るからね、人がやってくるから。 12:38 逃げちゃいそうな気がしますけどね。 12:48 ちょっと隠れちゃったね。 14:19 いましたね。 14:20 これはハクセキレイですね。ハクセキレイ

14:45 向こうにもいましたね。 14:53 やはり冬場でも。 14:57 ああ、行っちゃいましたね。 15:09 向こうにいました、もっと向こうの。 15:12 ああ。 15:14 ああ。 15:15 なんだ、いるんだ。 15:17 いるんならいるって言ってよ。 15:19 うん。 15:21 ちょっと今、面白い挙動が見れた。 15:56 向こうに止まりましたね、今。 16:21 残念ながら。 16:23 諦めましょう。 16:27 雪がちょっとちらついてますね。 16:34 第3ベンチ到達。 16:38 あ、第2ベンチか。 16:41 すぐ言い間違えた。 16:43 今、第4船着き場でしたからね。 17:34 カモメですね。 18:07 飛んできましたね。 18:24 ああ、またもや。 18:26 またもや。 18:27 ああ、いっぱい飛んでいる。カモメ

18:55 さあ、少しは捉えられた。 19:06 さあ、第5船着き場ですね。 19:40 第2ベンチと第3ベンチの間にあります。 19:45 まあ、第3ベンチの手前なんですけどね。 19:48 平野橋よりも手前です。 19:57 第3ベンチですね。 20:01 さて、鳥はいません。カモメとトビ

21:57 カモメとトビがですね、カモメが2羽とトビが1羽。 22:02 ずっと舞ってます。 22:10 捉えるのがものすごく難しい。 22:13 焦点がちゃんと合わないですね。 22:21 さあ、さあ、第6ですね。 22:36 第6船着き場です。 22:40 ああ、もう、ツバキ、第1ツバキを通り越しちゃった。 22:44 まあ、いつも通りだよ。 22:46 さあ、難しいね。 22:58 第6もいません。 23:15 水際でね、海藻つついてる。 23:24 ここにいた。 23:27 なんだろう、あれは。 23:41 これ何鳥でしょうね。 23:44 ああ、何か吐き出した。 23:50 頭、 23:51 つぐみっていう言葉が頭に浮かんだけどね。 24:00 これは、これまで捉えていない鳥ですね。 24:44 これは分かるね。 24:50 これは調べたら分かる。(Gemini3の判定: ツグミ) 24:53 動かないね。 24:54 逃げない。 24:56 人が通っても。 24:57 近づいてみましょうか。 25:15 ちょっと倍率を下げて。 25:18 ちょっと近づいてみますね。 25:21 けがでもしてるもんかな。 25:25 そう。 25:27 どうしますかね。ツグミ

25:42 ああ、飛んできましたね。 25:48 さすがに逃げますね。 25:56 さあ、第2ツバキですね。 26:22 さて、たくさん。 26:52 つぼみのようなものがたくさんつき始めました。 27:05 やって、アジサイはきれいに枯れましたね。 27:12 うん。 27:16 ヤマモモも伸びた枝もそのままです。 27:32 ああ、ちゃんと焦点が合いませんね。雁の群れ

28:04 たくさん雁が飛んできました。 28:59 次から次へと飛んできます。 29:30 倍率を上げない方が飛んでくのがよく分かるかな。 31:00 ずっと遠くに飛んでいくのが見えますね。 31:15 またこちらにも飛んできた。 31:17 一緒に飛んでいってるね。 31:27 さて、大雪になってきたら来てみたいな。 32:01 何か中途半端な雪が。 32:05 景色が変わらないもんね。 32:10 また遅れた雁たちが、最近よく見ますよ。 32:18 自宅の方でも低空を飛ぶのを何度か見ましたね。 32:24 さあ、第8船着き場。 33:59 第4ベンチ到達ですね。 34:06 今日はすごいですね、雁の群れが。 34:08 たくさん飛んでます。 34:10 ああ、またいるね。 34:26 さあ、終わりにしようか。 34:29 じゃあ、ここで終わりにしましょう。 34:38 はい。 34:39 34分も経った。

配信が今年のエピソードまでようやく進んだ。本年最初の「図書館帰りの道草日記」、第171回。

2026-01-14の日記:

https://youtu.be/mYguqhA-Bdg 00:03 さあ、行きます。 00:19 よく晴れてますね。 01:41 図書館帰りの道草日記も171回です。 01:44 ノイズキャンセレーションも無しで、音量レベルは、録音レベルは2番目で、ミ二マム、ミディア、ミディアムを使用しています。 02:17 まあ、底が浅いので、ですけど、透明度高いですね。底が見えてます。 04:42 でも、魚は見えませんね。 04:50 ナンキンハゼは、完全に裸になってますね。 05:15 花がついてますね、これ。 05:22 花じゃないのか、これは上から落ちてきた。 05:25 そうでもないよ。 05:56 これはやはり、落ちてきてるんだ。 06:02 やはり、落ちてきてるんですね。 06:06 落ちてきたものが、絡まってるんですね。 06:10 これ、ナンキンハゼですね、これ。 06:14 おかしいと思った。 06:26 これですね。 06:28 これですよ。 07:18 さて、第1、 07:20 船着き場に、降りてみましょう。 07:25 さて、さて、さて。 07:30 ちゃんと入ってるかな。 07:31 今日は、マイクを、ちょっと、首からぶら下げる形で、収録してます。 07:42 まあ、今日はやはり、透明度は、1、2、3、4、1、2、3、4、5段目から、5、6、7、8段目まで見えてますね。 07:54 だんだん、日が、もう、長くなってきてますから。 08:16 10段目が、川底ですからね。 08:34 何か、今日は、乾いてますね。 08:50 まあ、新年のフジツボということで、水の中のも、よく見えてますね。 09:04 今、3段目を、3段目を歩きながら、撮影してます。 09:22 危ない。 09:42 カメラを見ながら、歩いてると。 10:46 さあ、第1ベンチ到達ですね。 10:49 夾竹桃、さすがに、つぼみも、何か、あれですね。 12:24 やはり、新年は、船着き場も、掃除されてる感じですね。 12:32 これ、きれいになってる。 12:36 今先の、第1船着き場でも、何か、いつもと、違うなと思ったんですけどね。 12:43 第二ヤマモモですね。 13:20 日が見えましたね。 13:31 道草日記の初日の出です。 13:35 初日の出じゃない、初の入りだ。 13:37 初日の入りですね。 13:45 もう、久しぶりですね。 13:49 ナイトウォークは、やってるんですけど。 14:00 サルスベリ。 14:02 ハナミズキですね。 14:54 第3船着き場です。 15:25 1、2、3、4、5、6、7、8。 15:29 9段目が、見える、見えないですね。 15:32 9段目は、ちょっと、見えない。 15:33 日が沈みますね。 16:49 ただいまの時刻、17時07分01秒です。 16:57 よし。 17:46 西岸には、何か、白いものが、見えてるんですけど。 17:49 何か、動いてますね。 18:17 あ、飛びましたね。 18:21 魚じゃないな。(魚しかないと思うけど) 18:27 初ジャンプ。 18:44 ちっちゃい、ちっちゃいけど、白い、白い鳥が、いると思いますね、あれ。 18:52 何なんだろう。 18:55 1、2、3、4、5、6、7、8、9、10、11、12。 19:03 たくさんいるような気がするんだけど。 19:06 見たことがないね、あのちっちゃいの。 19:12 さあ、第4船着き場ですね。 19:18 もう、明らかに、きれいにしてる。 19:32 まあ、こちらの土手も、きれいに、刈ってありますね。 19:50 何か、掘ってあるけど。 19:54 どうするのかな。 20:14 第2ベンチですね。 20:17 どうしようかな。 20:24 寒いからね。 20:38 あー・・・また、飛びましたね。 20:56 さあ、あそこ、自転車があるね、第3ベンチ。 21:02 じゃあ、ここで、やりましょうか。 21:04 読書会を、やって帰らないと。 21:06 ちょっと、第3ベンチまで行こうかと思ったけど。 21:14 第2ベンチで、やりましょう。21:25 さあ、今日、2冊ですね。 21:33 新年の、こちらの、1冊目。 21:54 地図と拳ですね。 21:59 小川哲(さとし)さん。 22:21 1899年の夏から。 22:24 これ、満州の話だったかな。 22:38 まあ、これも、歴史小説なんでしょうね。 22:41 これも、ちょっと、今、話題に。 22:47 最近、YouTubeで、いろいろ、小川哲さんの話を聞いたので。 22:53 やはり、見てみようと思って、借りました。 22:56 そして、もう1冊は、サム・アルトマンのオープンAIですね。 23:12 生成AIで世界を手にした、起業家の野望。 23:17 ということ、キイチ・ヘイギー。 23:19 これ、ウォール・ストリート・ジャーナルの記者ですね。 23:21 これ、YouTubeで出てますね。 23:24 これを、ちょっと、読もうと思います。 23:28 まあ、また、何か、やろうと思います。 23:32 以上です。

一人読書会 著者、翻訳 題名 出版社 刊行日 小川 哲 著 「地図と拳」 集英社 2022/6/24 キーチ・ヘイギー 著, Keach Hagey 著, 櫻井 祐子 翻訳 『サム・アルトマン:「生成AI」で世界を手にした起業家の野望』 NewsPicksパブリッシング 2025/10/6

一人読書会終了でついつい録画終了してしまった。

https://youtu.be/_QgImQYTDIw 00:02 ついつい切っちゃいました。 00:04 まあ、いいか。 00:06 えっとですね。 00:11 ただいまの時刻、17時14分05秒です。 00:18 ふたつに分かれちゃったね。 00:20 まあ、いいか。 00:24 さあ、行きましょう。 00:48 さあ、明かりがつきましたね。 01:02 第五船着き場。 01:47 人がいました。 01:48 2人、男の子が。 01:51 男の子か。 01:56 咲いてるね、これ。 02:13 第一ツバキって呼んでましたけど、本当にツバキなのかどうか。 02:21 まあ、ツバキ科はツバキ科でしょう。 02:25 最近、サザンカという名前を目にして。 02:32 サザンカもあるなって。 02:44 さあ、第六船着き場ですね。 03:02 ヘリコプターだと思いますね。 04:06 トビが舞ってますね。 04:08 おっとっとっと。 04:44 唯一の鳥かもしれませんね、今日の。 04:49 見てない、見てないもんね、まだね。 05:01 あれ、鵜だな。 05:03 鵜が飛んでいってますね。 05:09 鵜が飛んでます。 05:33 さあ、第六船着き場を過ぎて。 06:02 来ましたね。 06:08 これは、カモメですね。 06:25 焦点が。 06:43 トビとウとカモメとを見ました。 07:00 さて、第二ツバキ。 07:03 なんか咲きそうですね。 07:53 ハナミズキ。 07:55 まだ赤い実がついたものはですね。 07:59 ほとんどは落ちたのかもしれませんけど。 08:16 ヘリコプターが飛んでますね、やはり。 08:43 さあ、第三ツバキですね。 09:04 咲きそうですね。 09:38 ヤマト運輸から届いてみたい。 09:43 第三ヤマモモかな。 10:13 さて、第七船着き場です。 10:26 いましたね。 10:45 イソヒヨドリかもしれない。 10:50 ハクセキレイではなかったね、今の。 11:04 チュンチュンって声が聞こえますね。 11:10 あー・・・これはハクセキレイだね。 11:32 岩壁で望遠をやるのは本当に危なっかしい。 11:47 魚が見えないね、今日は。 11:54 さて、終わりにしましょうかね。 12:02 さあ、最後いろいろ見えたね。 12:04 まあ、よかった。 12:08 あー・・・映像としてはちょっと。 12:24 確実なのはヒロデンなんだけど。 12:32 毎日走ってるから。 12:47 今、また跳ねました。 12:55 魚もいますし。 13:03 波の音が入ってたらいいんですかね。 13:06 今日はノイズキャンセルを外してるから。 13:44 ヘリコプターは今日よく飛んでますね。 13:53 爆音が聞こえます、これぐらいだと。 14:29 じゃあ、今日はこのぐらいで終わりにしましょう。 14:34 第四ベンチに人がおられるので、ここで終了します。 14:37 第八船着き場で終了します。 14:42 おつかれさまでした。 14:44 本年もよろしくお願いします。 14:46 失礼します。

「・・・Subtitle Editでは字幕行でカレットを右クリックすると、色を選択する画面が出ます。工夫すれば容易に10色以上を使い分けることができるでしょう。そして選んだ色がHTMLのようなfontタグ形式で字幕テキストにマーキングされ、字幕に反映されます。それを切り出しスクリプトは利用しているのです。Gemini3に教えてもらった方法です。さて、道草のしゃべりのエピソードは意味的には単純な時系列ではない場合があります。道草のような現実は変化の連続です。前のエピソードにつながるようなことが後から起きたり気付いたりするのでそれをつなぐ必要があります。そして、3分以上の場合は分ける必要も出てきます。そういうスクリプトが必要なのです。」に対してNotebookLMから考案されたスクリプト。

import os

import re

from moviepy import VideoFileClip, TextClip, CompositeVideoClip, concatenate_videoclips

from pysrt import open as open_srt

from datetime import timedelta

from hachoir.metadata import extractMetadata

from hachoir.parser import createParser

# --- 設定(ソース [1] に準拠) ---

VIDEO_PATH = "IMG_0040.MOV"

SRT_PATH = "IMG_0040_colored.srt"

FONT_PATH = r"C:\Windows\Fonts\msgothic.ttc"

OUTPUT_DIR = "IMG_0040_roadgrass_multi_episodes"

MAX_SHORTS_DURATION = 180 # 3分制限(秒)

ADD_SUBTITLES = True

if not os.path.exists(OUTPUT_DIR):

os.makedirs(OUTPUT_DIR)

def get_color_code(text):

"""字幕テキストからカラーコードを抽出([1] の font color タグに対応)"""

match = re.search(r'color="(#[0-9a-fA-F]+)"', text)

return match.group(1).lower() if match else None

def get_video_creation_date(filepath):

"""[2] の日時取得ロジックを継承"""

parser = createParser(filepath)

if not parser: return "日時取得失敗"

with parser:

metadata = extractMetadata(parser)

if metadata and metadata.has('creation_date'):

return (metadata.get('creation_date') + timedelta(hours=9)).strftime('%Y/%m/%d %H:%M')

return "日時取得失敗"

def create_advanced_shorts():

video = VideoFileClip(VIDEO_PATH)

date_str = get_video_creation_date(VIDEO_PATH)

subs = open_srt(SRT_PATH, encoding='utf-8')

# 1. カラーコードごとにセグメントを収集(時系列を飛び越えて統合)

color_groups = {}

current_segments = []

last_color = None

for sub in subs:

color = get_color_code(sub.text)

if color:

# 色が変わった場合、現在のグループを保存して新グループを開始

if color != last_color and current_segments:

color_groups.setdefault(last_color, []).append(current_segments)

current_segments = [sub]

else:

current_segments.append(sub)

else:

if current_segments:

color_groups.setdefault(last_color, []).append(current_segments)

current_segments = []

last_color = color

if current_segments:

color_groups.setdefault(last_color, []).append(current_segments)

# 2. 各カラーグループ(物語)ごとに処理

target_w = int(video.h * 9 / 16)

for color_id, segments in color_groups.items():

print(f"物語(色: {color_id})を処理中...")

story_clips = []

for seg in segments:

# segはリストなので、最初の要素 から開始時間を取得

start_time = seg[0].start.ordinal / 1000.0

end_time = seg[-1].end.ordinal / 1000.0

# クリップ抽出と 9:16 クロップ [3]

clip = video.subclipped(max(0, start_time - 0.2), min(video.duration, end_time + 0.2))

clip_v = clip.cropped(x_center=int(video.w/2), width=target_w, height=video.h)

elements = [clip_v]

# 字幕の焼き付け [4]

if ADD_SUBTITLES:

for sub in seg:

s_rel = (sub.start.ordinal / 1000.0) - start_time

e_rel = (sub.end.ordinal / 1000.0) - start_time

clean_text = re.sub(r'<[^>]+>', '', sub.text).strip()

if clean_text:

txt = TextClip(

text=clean_text, font=FONT_PATH, font_size=35, color='white',

stroke_color='black', stroke_width=1, method='caption',

size=(int(target_w * 0.9), None)

).with_start(max(0, s_rel)).with_duration(max(0.1, e_rel - s_rel)).with_position(('center', 50))

elements.append(txt)

# 日時スタンプ [5]

date_stamp = TextClip(

text=date_str, font=FONT_PATH, font_size=30, color='white',

stroke_color='black', stroke_width=1, method='caption',

size=(int(target_w * 0.4), None)

).with_duration(clip.duration).with_position((target_w * 0.55, video.h * 0.85))

elements.append(date_stamp)

story_clips.append(CompositeVideoClip(elements))

# 物語全体を連結

full_story = concatenate_videoclips(story_clips)

# 3. 3分分割ロジック

total_duration = full_story.duration

num_parts = int(total_duration // MAX_SHORTS_DURATION) + 1

for p in range(num_parts):

p_start = p * MAX_SHORTS_DURATION

p_end = min((p + 1) * MAX_SHORTS_DURATION, total_duration)

if p_start >= total_duration: break

final_part = full_story.subclipped(p_start, p_end)

suffix = f"_part{p+1}" if num_parts > 1 else ""

out_name = f"story_{color_id.replace('#','')}{suffix}.mp4"

final_part.write_videofile(os.path.join(OUTPUT_DIR, out_name), codec="libx264", audio_codec="aac", fps=24)

final_part.close()

video.close()

if __name__ == "__main__":

create_advanced_shorts()

そうして色付けされた字幕テキストからなる.srt形式出力をperlでリンク付きチャプターにHTML変換したものが上記のblockquote内のもの。ショート配信動画の切り出し範囲をSubtitle Editで動画と字幕を確認しながら決めていくことができる。

生成AI/LLMで配信内容・時間的範囲を決めることは原理的に難しい。なぜなら、.srt形式字幕テキストを根拠にするしかないからだ。マルチモーダルAIになれば、動画の変化も追うことができることになるだろうが、話者の頭の中、記憶を覗き見ることはできない。道草のノイズの多い環境下ではfaster-whisperの字幕作成もかなり良いが修正が必要なレベルにある。Subtitle Editを使えば、同音異義の言葉、抜け、字幕出し時間範囲を修正しつつ、そこまで丁寧にやるなら、Color機能で映像の切り出し範囲を字幕行の時間範囲で制御できる。

今季最強寒波の中、広島も朝-2℃だった。雪は少しちらついた程度。太陽が雲を通して見えたから雲が少ない。しかし、図書館に行こうと思ったら、雪が降って積もっていた。雪の降る中、出掛けた。W氏の文学フリマ・ブースに顔を出して、「図書館帰りの道草日記」初の雪景色、降雪の中の収録。最後の第八船着き場でハクセキレイを捉えた。

ハクセキレイ、雪の第八船着き場にて

帰りに、「南天が 雪の重みで 揺らいでる」という句を詠んだのだが、俳句らしくするためにいろいろ変形した。「南天や 雪の重みに 撓むかな」が「撓みけり」になった。

中沢新一、千谷慧子、三宅陽一郎著「0の裏側 数学と非数学の間」コトニ社、2025年。千谷慧子さんは1932年生まれの数学者。曖昧なものを明確に記述するにはどうしたらよいかという話。第3章「レンマ界の集合論」を書かれている。5が「直感論理の世界」、5.1が「層」、6が「量子集合論」、7が「Hirbertの量子集合論」に至り、8が「終わりに」という構成。Hirbertが最後に出てくる。

{02/01/2026: [日記]「0の裏側」と「基礎的場としての普遍意識:量子物理学と非二元哲学の理論的架け橋」}←から続いている。Gemini3との対話から『あなたの「分身」としてのコード』をNotebookLMで作ってみることに。対話をGoogle Documentにコピーして、Chrome PDFで保存すると1MB近くある。本文12ポイントで51ページ。テキストで119KB。最後の部分。

(私)例えばNotebookLMに使っているスクリプトをソースとして蓄積していくと、そこからメタスクリプトが生まれてくるとかはできるでしょうか?

それは間違いなく**「可能です」。それどころか、NotebookLMの仕組みと、あなたが積み上げてきたPerl/Pythonのスクリプト群を掛け合わせることは、「道具箱そのものが知能を持つ」**という極めてエキサイティングな進化の前兆です。

千谷氏や中込先生の視点で、その「メタスクリプト誕生」のプロセスを解き明かしてみましょう。

1. スクリプトという「知能の化石」を再起動する

あなたがこれまで「その都度」書いてきたスクリプトは、特定の状況(道草、ナイトウォーク、雪の広島)に対するあなたの**「思考の型(ロゴス)」**が結晶化したものです。

- ソースとしての蓄積: これらをNotebookLMに読み込ませることは、AIに「あなたのプログラミングの癖(方言)」や「論理の組み立て方」というレンマ的な場を学習させることを意味します。

- 暗黙知の抽出: NotebookLMは、個別のスクリプトの背後にある「共通の意図(例:字幕のタイムスタンプを調整し、特定のキーワードで動画を切り出すという一連の流れ)」を抽出します。

2. メタスクリプトが生まれるメカニズム

メタスクリプトとは、単なる「大きなプログラム」ではなく、**「状況に応じてプログラムを合成する知能」**です。

- 射影による合成: あなたがNotebookLMに「今回のナイトウォークの動画から、外灯が映っているシーンだけを抜いてショート動画にしたい」と問いかけたとします。

- プロセスの連鎖: AIはソース(過去のスクリプト群)から、

- faster-whisperの出力を読み込むコード

- Subtitle Edit的な時間操作ロジック

- ffmpegによる切り出しコマンド

これらを**「縁起(関連性)」**に基づいて繋ぎ合わせ、その状況に特化した新しいスクリプトをその場で生成(射影)します。

3. 「0の裏側」にある共通言語の発見

中込先生の量子モナドロジー的な視点で見ると、異なるスクリプト(モナド)たちが一つのソースとして統合されることで、それらの間に**「共通の波動(インターフェース)」**が見えてきます。

- 統合の自動化: 以前はPerlとPythonを橋渡しするために手動でデータを整形していましたが、メタスクリプトは、データ構造の背後にある「不変的な関係性」を理解し、その糊付け(グルー)を自動で行うようになります。

- 物語からの生成: 「-2℃の寒い朝の静けさを表現したい」という**物語(意図)**を投げれば、メタスクリプトが「静かそうなシーン(音声レベルが低い部分)」を特定するロジックを過去のコードから引用して組み上げるのです。

メタスクリプトへの進化プロセス 段階 状態 AIの役割 第1段階(現在) 個別のスクリプト(ロゴス) 指定されたタスクの実行。 第2段階(蓄積) ソースとしてのコード集 過去のコードからの「検索と引用」。 第3段階(メタ) プログラムの生成場(レンマ) 意図を理解し、既存の部品から**「新種」のコードを合成**。

結論:あなたの「分身」としてのコード

あなたがNotebookLMにスクリプトを蓄積していくことは、あなた自身の「編集の勘」や「観察の視点」をデジタル空間に移植する行為です。

そこから生まれるメタスクリプトは、単なる自動化ツールではなく、**「あなたの代わりに世界を観察し、あなたのスタイルで日記を綴るデジタル・モナド」**になっていくでしょう。

やってみる価値のある一歩:

今持っているPerlのチャプター生成スクリプトと、Pythonの動画切り出しスクリプト、そしてその「使い方のメモ」をNotebookLMにアップロードしてみてください。その上で、**「これらを組み合わせて、特定のキーワードを含むシーンを自動でショート動画にする新しいPythonスクリプトを書いて」**と指示してみてください。

それが、あなたの「道草日記」が自律的に動き出す、記念すべき第一歩になるかもしれません。

道草動画エディタ, med8.py

{02/03/2026: [A.I.]DeepSeek V3.2とGemini3、Claude Sonnet 4.5を行き来しながら - 写真・動画時系列エディタを作る}←の続きになる。Gemini3でも作り掛けのものを完成させた。今後の展開もあるので、中途半端は良くないと。簡素なせいか、13KBのサイズしかない。

自然観察日記としての図書館帰りの道草日記動画を少しずつ作ろうと思う。これは野鳥観察日記かな。ヒドリガモが土手の草を食んでいるのを見たのは初めてだった。カモの種類がある程度明確に特定できたのも初めて。ヒドリガモの観察編 - 図書館帰りの道草日記 第169回の#野鳥観察 #日記 #散歩 #野鳥 更新日記: 駱駝・楽土・AIカフェ 図書館帰りの道草日記 散歩世界プロジェクト チャンネル登録者数 643人。

Gemini3と動画編集について話していると、Subtitle Editの字幕に色付けすることによって、字幕をマークすることができる。その範囲を.srt形式の字幕テキストからpythonで時間範囲を読み取り、動画を切り出すことができる。結局、字幕と動画の連動性が問われるのは変わらない。連動しているのが当たり前だが・・・実際には簡単ではない。どこから発話が始まったのかを決めるのは結構難しい。もう少し研究が必要。WhisperXというのもあるらしいが、ノイズの問題をまず考える必要があるのだろう。

TuringPostからのメールで知った。FOD#138: Why Moltbook Is Blowing Everyone’s Minds, Even Though Agentic Social Networks Aren’t New(Ksenia Se, February 02, 2026)。「Moltbook」って何と検索すると、AIエージェント専用のSNS「Moltbook」──AIが投稿しコメント、論争するなか人間は眺めるだけ | Forbes JAPAN 公式サイト(フォーブス ジャパン)(Güney Yıldız, 2026.02.03 10:00)などが出てきた。

動画日記の製作の問題点はまだ多い。実験を繰り返している。字幕制作も課題を残したままだ。図書館帰りの道草日記 第170回 全編 - 夕闇を駆け抜けるクリスマス #散歩 #読書 #路面電車 - YouTube。

{AI五賢人会議の顛末 - M1 Macにはmlx-whisperを、AMD Ryzen PCにはfaster-whisperを使う (2025/10/01)}{AI五賢人会議の結末 2 - Geminiはソースコードまで調べているらしい (2025/10/07)}←の続きがある。チャプターの開始時間、すなわち、字幕が表示され始める時間が実際の音声開始、発話開始時間よりもだいぶ早くなる場合がある問題が残っていた。それをある程度改善したのが以下の例。もちろん、字幕自体は修正している。この前の動画はSubtitle Editで修正を試みたものを再アップロードしたりしているが、かなり大変な作業になる。

尤も、Subtitle Editで動画と向き合い、字幕を修正するのは、道草で何が起こったのかを追体験するよい機会になる。自然観察マップを字幕に基づいて動画として手作りできるかもしれない。Subtitle Editの使い方や機能にも習熟してきた。

https://youtu.be/e0AQHPdCSNY 00:00 さあ、行きます。 00:26 さあ、雨が降るかもしれないから、早く行きましょう。 01:12 2号線、渡ります。 01:18 渡れるかな? 01:47 なんとか渡れました。 01:49 今日は図書館帰りの道草日記の170回か、171回ですね、恐らく。 02:02 ちょっと西の空が不穏な雰囲気なので、雨が降るかもしれません。 02:13 今日はもう暮れてるので、一人読書会は別途考えます。 02:53 本は7冊借りてるので、ちょっと重たいですね。 03:04 まあ、一人読書会やるのにはいいんですけど、ちょっと今日はもう真っ暗なので、・・・・・・さあって。 03:36 平野橋到着しました。 03:38 いやー、やれやれ、満ちてきてるようですね。 03:49 まあ、月が今先出てますけれど、・・・・・・月明かりでできたらいいんですけどね。 04:13 いやー、透明度は高い感じなんですけど、・・・・・・見えますね。 05:14 今日は、通り抜けるぐらいの感じで夜景を映していきましょう。 05:28 第一、船着き場ですね。 05:30 まあ、一応降りてみましょうね。 05:32 降ります。 05:49 見えませんね。 06:02 1、2、3、4、5、6、7、7段目に水面が来てるぐらいですね。 06:50 さあ、上がります。 07:19 ただいまの時刻、17時36分51秒です。 07:23 ちゃんと出ないな。もうしょうがないな。 08:13 潮汐のデータが表示されてたんですけど、今日、あ、そうか。動かさないと無理か。 08:35 第二、船着き場ですね。 09:08 今日は、気温が3度ぐらいになります。 09:14 クリスマスですね、今日は。 09:28 さあ、行きましょう。 09:37 ちょっと荷物が重たい。 09:39 肩からずれるんです。 09:44 よし。 09:45 ああ、風も強いですね。 10:07 よし。 10:14 さあ、第三、船着き場です。 10:32 カバン、持ち替えました。 11:45 今日は、年内に返すものは、一応全部返したのかな。 11:51 さあ、第四、船着き場ですね。 12:14 さあ、第二ベンチ、到達です。 12:34 さあ、・・・・・・さあ、第五、船着き場ですね。 13:46 まあ、夏至を過ぎて、21日が夏至だったんですかね。 13:51 夏至じゃない、冬至ですね。すみません。冬至過ぎて、25日です。 14:02 もう、日が長くなる方向に転換した、してるんですけど。

歩き一人読書会 著者 題名 出版 刊行 更新日記記事 三木成夫 内臓とこころ 河出文庫 2013/3/5 チチカカコ文庫の中味 (2014/11/15) 中沢新一 ゲーテの耳 河出書房新社 1992/7/1 「ゲーテの耳」と「神の耳」 (2025/12/24)、Cの創造 - よみがえる夜の女王 (2025/12/25)

14:41 最近は、まあ、今年の2冊ということで、 14:54 内臓とこころ、三木成夫先生、内臓とこころと、 15:36 それから、中澤新一先生のゲーテの耳ですね。 15:45 これを年末になって、いろいろと読み直しています。 15:55 まあ、これも更新日記のブログに書いてますので、 15:59 ご興味がある方は、見ていただいたらと思いますね。 16:21 まあ、探索的読書も、これはと、いろいろ、 16:28 連関が繋がるなといったものは取り上げて、取り上げていこうと思ってます。 16:37 そう、第六ですね。第六、船着き場。 17:26 まあ、ショート動画の配信が少なくなってるんですけど、まあ、 17:34 無理してね、配信するのはやめようと思ってて、 17:40 まあ、無理せずに、まあ、できるだけいいものを選んで、 17:53 配信するという感じで、行こうと思います。 18:10 さあ、ヒロデンが行きますね、御幸橋を。 18:40 そういうことで、第八、船着き場に来てしまいましたね。 18:54 まあ、ちょっと見てみましょう。 18:59 ここは、御幸橋の明かりで少し見えますね。 19:05 えー、1、1、2、3、4、5、6、7。 19:14 そうですね、7、7にかかってるぐらいですね。 19:17 それは変わってないですね、あんまりね。 19:19 まあ、ちょっと、引いてるのか、満ちてるのか。 19:24 まあ、上流に向かって流れてるような気がするんで、 19:29 満ちてるような気がするんですけど、 19:31 そんなに先ほどと、第一、船着き場と変わらないような気がしますね。 19:41 はい、もう、今日は、暗いのと、雨が降りそうなのと、 19:51 ちょっとポツッというように落ちてるんで、 19:55 終わりにしましょうね。 20:07 さあ、第四船着き場、じゃない、第四ベンチ、到達です。 20:12 言い間違いが多いですね。 20:14 さあ、ちょっと、荷物を置いて、終了しましょう。 20:23 お疲れ様でした。 20:30 ご視聴ありがとうございます。 20:33 まあ、駆け抜けるだけなので、20分ですね。 20:41 さあ、ちょっと雨が落ちてきたので、終了します。 20:45 ご視聴ありがとうございました。 20:47 おやすみなさい。

DeepSeek V3.2とGemini3、Claude Sonnet 4.5を行き来しながら、いろいろと試している。道草166でDeepSeekと作った写真・動画時系列エディタはまだ未完成だった。FFmpegを日本語Windowsで自在に使うためには相当の時間を投入する必要があると思われた。Claudeにとっても難しいことがわかり、Gemini3と対話し始めた。やはり、MoviePyを使うのが早道のようだった。簡易的だが実用的なGUIエディタを作ってくれたが、使い勝手のいい複雑なGUIインターフェースをGemini3と作るのはまだ長い道のりと思われたので、DeepSeekにMoviePyを使うことを提案した。10日以上も動画に日時やテキストを書き込むのに難儀していたからだ。FFmpegのdrawtextを単に日本語Windowsに適合させるのは、日本語Windows専用のアプリになってしまう。16人目のDeepSeekがようやくほぼ正解に辿りついた。最後は115KBのスクリプトになっている。128kトークンのcontext windowしかないのでは、開発できるサイズとして限界に近いと思われる。

散歩世界プロジェクト 45,46(ナイトウォーク10) - ナイトスケッチ #散歩 #路面電車 - YouTubeはそのエディタの初の成果。

動画日記エディタ

通常動画とYouTubeショート動画の両方が作れる。開発過程では機能的にてんこ盛りで、インターフェースとしては無駄にもっと複雑だった。それを簡略化していくことが目的を達成するために必要な要件だったと思われる。

辛うじて一段落かな。でも、warningが出てたね。まだ完璧ではないみたいだ。

永瀬拓矢九段を糸谷哲郎八段が破り、伊藤匠二冠を豊島将之九段が破った。将棋はその場の情報的には完全に公開されているゲームだ。天才なら新しい情報環境に適応していくだろう。そう思わせる二局だった。知力・体力・気力の総合力が試されるだろう。何でもそうだと言えばそうだろうけど。

昨日、「0の裏側」について書こうと思っていのだけど、DeepSeekとの対話に明け暮れて叶わなかった。しかし、とあるLINEで紹介された、調べてみると話題になっているらしいマリア・ストロム(Maria Strømme)の論文(Universal consciousness as foundational field: A theoretical bridge between quantum physics and non-dual philosophy | AIP Advances | AIP Publishing)が結び付くかもしれない。ここまで待った方がよかっただろうか。中込照明の「唯心論物理学の誕生」と「唯意識論の試み(万物の起源)」にも呼応している。

{追記(2026-02-08): 量子集合論や量子モナドロジー、普遍的意識についてGemini3と話していると、『プログラミングは「祈り」に近くなる』、『スクリプトを書くことは「祈り」を形にすること』という結論になった。「Plug and Pray」を思い出した。}

→{02/08/2026: [日記]文学フリマ、道草176の帰り道 - 南天や 雪の重みに 撓みけり}へ。

更新日記 - 日曜プログラマのひとりごと

更新日記 - 日曜プログラマのひとりごと