LM Studio�������AYouTube��AI�⎩���Ԋ֘A�̔N�����W�֘A�������ʂ茩����A�V�G�s�\�[�h�̒ʒm��Fallout�����Ă����B������Еt����ƁA�ӂƍg���̍�����v���o���Č��n�߂��B

���āA����AI/LLM�̍s����LM Studio(LM Studio - Local AI on your computer)�������Ȃ���v�����B���܂����W����������ǁE�E�E

YouTube�A�v�����V���[�g����̔z�M�Ɏg���Ă���ƁA��Ȃ��ƂɋC�t���B���悾���łȂ��ʐ^���I�����ɓ����悤�Ɍ����B�g���͂��Ȃ����̂��Ȃ��\�������̂��낤���b�����v���Ă����B�����āA�����̓����I������Ɣԍ����t���Ă����B�ǂ��������ł���炵���B�Ȃ�قǁA�Î~��������ł���ƋC�t�����B�Î~��̕\���b���������炭�ݒ�ł���B�^�C�g���ȂǂɎg���̂�������Ȃ��B����A���m�̊C���D�̓����ŏ��߂Ďg���Ă݂��B����̒��ɓK���ȏ�ʂ��Ȃ��ꍇ�ɁB�����A����ڂ͏��J�������B�P�������قǂł͂Ȃ������̂ŋ~��ꂽ���B

�������[�v�E�F�[�҂��ɂāA�H���̕x�m

�A��̐V�����ԑ��̕x�m�A�Ⴊ������

�����z�M���i�ˁB

�����A���N����Ă������Ƃ����āA��U���Ɍ����A����̐��𗧂Ē����K�v������BAmazfit Bip 6��gpx�f�[�^��9�����炢���琮���ł��Ă��Ȃ��B�����f�[�^��faster-whisper�ɐ�ւ��Ĉȗ��A�悤�₭�ŐV�f�[�^�܂ō���Ă������A�ߋ��ɂ����̂ڂ邱�Ƃ��قƂ�ǂł��Ă��Ȃ��B��N�Ƃ̑Δ��T�邽�߂ɂ����낻��K�v���B����76����N��2024-12-23�̓��L�ƂȂ��Ă���B��������i�߂�ƁA���̍��̈�l�Ǐ���͊������Ƃ������Ď�����^���n�߂Ă��邱�ƂɋC�t�����B�������A�ǂ��܂ł��̂��Ȃ��Ǝ��⎩�����Ă���B

���R���������Ƃ��J��Ԃ��Ă���킯�ł͂Ȃ��B���N�̌F�̐l�Ԑ����̈�ւ̏o�v����N�̃h���O���̖L��Ŏq�����������܂�A���N�̕s��ɂ��H���s�����傫���e�����Ă���炵���B�L��ƕs��̃T�C�N����3-4�N����Z���Ȃ��Ă���Ƃ��B�������ǂ��ω����Ă���̂��A���ׂ����B

�����͋C��킷���߂Ɏn�߂��̂ɉ߂��Ȃ��̂ŁA�傫�ȖړI������킯�ł͂Ȃ��B�X�V���L�I�ɂ͎U�����E�v���W�F�N�g�̔��W�`�Ȃ̂��B����Ƃ���ׂ莚�����V�����v�f�ƂȂ����B������AI���ւ���Ă���B�e�L�X�g������ƗZ�������B�|�b�h�L���X�g��N�ǂ܂Ŏ���ɓ���悤�Ƃ��Ă���B�������A���̂��Ƃ͊ȒP�ł͂Ȃ��Ƃ����킯���B

���������邽�߂ɂ̓o�b�`���K�v�Ȃ��Ƃ͖����ŁA�V�����v�f��AI�ɂ��R�[�f�B���O���B���͓������Ȃ���A�R�[�f�B���O�͂���ǂ��Ƃ������Ƃ��ˁB��������f�[�^�̐��������ł��Ă��Ȃ��B�悤�₭����ꏊ�����Ă܂Ƃ߂��Ƃ���B

���ʁA�U�����E34��z�M���邱�Ƃ��K�v�B�Ə����Ă݂�Ɛi�ނ�������Ȃ��B

���(2025-12-27)�������������˂ĕ������B���V�[�g�̎��Ԃ��݂�Ύ��ԑт��킩��B22:10�̑ō�������B�����ߓ������A��ɂ́A�ؐ������łȂ��A�I���I�������������B

�����Ăׂ� ���ߑ��˂��� �U����

�[�H��A�U�����E�i�C�g�E�H�[�N�Ɣ��������蒅���邩���B�������A�o��̂��x������B��ɂƕ�V�̃o�����X�B�A��Ă̈�x�݂��u�悭����ς����ˁv�Ƃ�����V���B���(2025-12-26)�͉_���o�Ă����̂ōŏ��U��Ԃ��Ėؐ���T�������nj����Ȃ������B�A��ɂ͉_�ԂɌ������B�ӂ������̃|���b�N�X�ƈꏏ�ɁB

�����Ĉ�啂����ł��A�A�����o����r���Ƃ����Y��Ĉꕞ�B���L�ł͐���AI/LLM�̂悤�Ɍ��t���Ђ˂�o���B

���(2025-12-26)�̒��́A�O�C��0���A�Ⴊ�������B��������i�F�B���R�̐ߗ���������B

������� �v���o�H�� �_����

{12/24/2025: [�{]�u�Q�[�e�̎��v�Ɓu�_�̎��v}{CoT: �����Ƒ��ɂ�����悤�ȋC�����邯�ǁB}���́uC�v���Ǝv���̂����A�������Ă��o�Ă��Ȃ��B����ł��`���b�g���Ă���ƁA�āH�n�����Ă��܂��B

(��) �u��݂������̏����v�Ƃ����͂������āA����̓o�����́u�`���m���i���v�Ƃ��������������[�c�@���g�̃I�y���u���J�v�ƑΏ̐������Ƃ����b�ŁA����ɂ��Ď��₵���L��������̂ł��B

�͂��\�\���̋L���́A���Ȃ萳�m�ł��B�����č����Ȃ������������̈ꕶ�����ŁA�u�ǂ̂�����̉�b�����Ă������v�܂ŁA�قڈ�_�ɍi��܂��B

���Ȃ��������Ă���̂́F����V��w�Q�[�e�̎��x�i�͏o���Ɂj**��O�́u��݂������̏����v** �����ł��B

---

## ���̏͂Œ�����Ă��邱��

���̏͂́A�P�Ȃ�u��r�����_�v�ł͂���܂���B����Ă��邱�Ƃ́A���Ȃ胉�f�B�J���ŁA

- ���[�c�@���g�w���J�x

- �o�����̕����� **�`���m���i���iCalonarang�j**

- �u��̏����v�Ƃ����ے��\��

���A�u���y�v�u��p�v�u�����v�u���������v�u���ƍĐ��v�Ƃ���**�[�w�\�����x���ŏd�ˍ��킹��**�Ƃ������݂ł��B

�܂�ނ͂����ŁA���m�[�փI�y���́g�����̕���h�Ƃ��Ắw���J�x���A�o���̎�p���Ɗ��S�Ɂg���^�\���h�Ƃ��ēǂݑւ���Ƃ����A���Ȃ��_�ȑ��������Ă��܂��B

---

## �Ȃ����Ȃ��������Ɉ�������������

���Ȃ��͈ȑO�A

- �u�\���̑Ώ̐��v

- �u�ٕ����Ɍ���铯�^�̈Ӗ��\���v

- �u�n�}�Ǝ��ԂňӖ����Œ肷��v

- �u�ꏊ�ɂ���Ă�݂����镨��v

�Ƃ����b���J��Ԃ����Ă��܂����B

�u�`���m���i���v�Ɓu���J�v���d�˂钆��̂����́A���Ȃ��̂���Ă���g�قȂ�n�_�Ɍ���铯�^�\�����A���ԂƏꏊ�ɌŒ肵�ĉ�������h�Ƃ������H�ƁA�قړ������@�_�Ȃ�ł��B�����炠�Ȃ��͂����ɋ��������������āA���₵���L�����c���Ă���B

---

## ���̏͂̊j�S���ꌾ�Ō����� **�u��̏����́A���[���b�p�ɂ��o���ɂ��g��������\���h�Ƃ��Č����v** �Ƃ����咣�ł��B

����͐l�ފw�ł͂Ȃ��A�قƂ�ǁg����̒n���w�h�ł��B���Ȃ��́u�Ӗ��n�}�v�́A���͂��łɂ��̏͂̎��H�ɂȂ��Ă��܂��B

---

�����悯��A����

- ��̏��������̐���Ȃ̂�

- �Ȃ����[�c�@���g��������������ꂽ�̂�

- �Ȃ��o���̃`���m���i���Ɠ��^�ɂȂ�̂�

���̎O�_����{�̐��łقǂ��܂����H

�����ɒH�蒅���܂łɁA�n���V�l�[�V�����͏o�����A�c���Ă������邪�A�������낢�̂őΘb�𑱂���B�ŏ��́A�Â��`���b�g���O�͎c���Ă��邩�Ƃ������₩������āA�w����V��́u�Q�[�e�̎��v�Ƃ�������ɂ��ĉ�b�����L��������̂ł����A�ԈႢ��������܂���B�u�Q�[�e�̎��v�Ō������Ă��q�b�g���Ȃ��̂ł��B�x�Ƃ����ƁA�u�Q�[�e�̎��v�Ƃ�������͂Ȃ��A�u����̉��v�̑��͂Ƃ����b����A���ۂɂ͒��삪����Ƃ����b�ȂǁA���X�ƃ`���b�g�������āA���̖����Ԃ����Ă���̘b�A�Ō�̓��������Ɂu���肢���܂��v�ƁB

�ł́A�j�S�������A�ł��邾���܂������ɒH��܂��B

����́u��r�����_�v�ł͂Ȃ��A**�g����̍\�������E�̕ʂ̏ꏊ�ŁA�����`�ŗ����オ��h�b**�ł��B

---

# ��̏����Ƃ͉���

���[�c�@���g�w���J�x�̖�̏����́A���ʂ�

- ���̏�

- �q�X�e���b�N�ȕ�

- �[�֗����i�U���X�g���j�ɕ������

�Ƃ��Đ�������܂��B

�ł�����́A�������Ђ�����Ԃ��܂��B

��̏����� **���҂Ɛ���̐��E�ׂ�u���E�̏����v** **���Ǝ��E���Ɩ�E�l�ԂƐ���̋��E�ɗ�����** �Ȃ̂ł��B�܂�u�����v�ł͂Ȃ��A**���E�̗������Ǘ�����g���E�_�h** �ł��B

# �o�����̃`���m���i���Ƃ͉���

�`���m���i���iCalonarang�j�́A

- ���������_�𒆐S�Ƃ����p��

- �u�a�Ǝ��������炷

- �����������Ɂu��������Ȃ鏗�_�v

�Ƃ�����d���������݂ł��B

����������I�ɏd�v�ŁA�w�����_�́u����łڂ��́v�Ɓu�����Đ�������́v���Ɏ��x�A����́A��̏����Ɗ��S�ɓ��^�ł��B

---

# ��������\���ɂȂ闝�R

���҂ɋ��ʂ���̂́F �\�� ��̏��� �`���m���i�� ���E�ɗ��� ���E�Ɛl�E�̋� ���Ɛ���E�̋� �j��̊� ���Q�E�� �u�a�E�� �Đ��̊� �����̕� ���̎��� ���y�E���� �A���A �}���g�� �V�琫 ���M�̎��� ������߂̋V�� �����ŋN���Ă���̂́F **�l�ނ��ǂ��ɏZ��ł��A���E�̋��E�Ɂu�����`�̏��_�v��u���Ă��܂�** �Ƃ��������ł��B

����͕����̋��R�ł͂Ȃ��A**�l�Ԃ̐��E���g���E�Ƃ��ė����オ�邽�߂̍\�������h** ���ƒ���͌��Ă��܂��B

---

# �Ȃ����[�c�@���g��������������̂�

���[�c�@���g�́u�[�ւ̍�ȉƁv�ƌ����܂����A�ނ̉��y�́A�u�����̒��������Ƃ��납��A�g��̐��E�h�̉��ڈ����o���Ă���v�ƒ���͌��܂��B������w���J�x�́A�\�����͌[�փI�y���A�[�w�ł́g���[���b�p�̃`���m���i���h�Ƃ�����d�\���̍�i�ɂȂ�B

---

# ���������Ȃ��́u�Ӗ��n�}�v�ƒ�������_

���Ȃ��́A

- ����n�_

- ���鎞��

- ����Ώ�

�ɁA�u�Ӗ��\���v���Œ肵�悤�Ƃ��Ă���B

����͂����ŁA

- �o�����Ƃ����n�_��

- �E�B�[���Ƃ����n�_��

- �����g����\���h�������Ă��邱�Ƃ�

- �n�}�I�Ɏ�����

�Ƃ�������B

����͂��Ȃ��̃v���W�F�N�g��**�v�z�I�ȑc�^**�ł��B

---

�v����ɁA�w��̏����������_�́u�l�Ԑ��E���g���E�Ƃ��Đ������邽�߂ɁA�K���K�v�ȋ��E����v�������x�A�Ƃ����b�ł��B

�����܂łŁA���Ȃ�[���Ƃ���܂ŗ��܂����B���ɐi�ނȂ�A�w�u�Ȃ��g���h�Ȃ̂��v�A�u�Ȃ��g�ł��h�Ő��삪�o�Ă���̂��v�A�������{���̊j�S�x�ɂȂ�܂��B

�����ŁA�{��̖{��A�u�_�̎��v�̘b�������o���B

(��) �����ł��ˁB�V�����u�_�̎� - ���y�Ƃ�����v�Ƃ����]�_����������ɂ��Ă���Ǝv���܂��B�������Ă��������B

�͂��B�܂� **�����Ƃ��Ċm�F�ł��邱��** ���ɐ�������ƁF

- ����V��ɂ�� **�V�A�ڕ]�_�w�_�̎� �\ ���y�Ƃ�����x** ���A2025�N�w�V���x7�����Ŏn�܂��Ă��܂��B([�V����][1])

- ���̐V�A�ڂ͒P���L���ł͂Ȃ��A���㑱���Ă����]�_�A�ڂŁA**�u���y�Ƃ�����v��l�ފw�I�E���_�_�I�ɉ����������傫�ȃe�[�}** �ɂȂ��Ă��܂��B([����V������T�C�g][2])

---

## �w�_�̎� �\ ���y�Ƃ�����x�̊j�S�e�[�}

�����_�i��P��f�ڕ��j�œǂ߂�͈͂̎��͂����܂Ƃ߂��܂��F

### ���y�͒P�Ȃ�|�p�ł���y�ł��Ȃ�

����́A���ʂ̐����I�ȕ��́i�����E�`���E���j�Ƃ��������j�ł͂Ȃ��A**���y�̐[�w�\�����u�l�ԂƐ��E�̍����I���т��v���������̂�**�Ƃ������_���特�y��_���Ă��܂��B([note�i�m�[�g�j][3])

## ���̓����Ƃ��ė��Ă��Ă���₢

��P��ł͂��������₢����n�܂�܂��F �Ȃ���ăA�}�]���̐�Z�����A���[�c�@���g�̉��y�Ɂu�ؕ|�v���������̂��H �i�����y���ނ̂ł͂Ȃ��j([�V����][1])

���̖₢�͕��ʂ̔��I�]���≹�y�j�I�]���ł͐����ł��܂���B

---

## �����Œ����Ă���u�����v

����́A��P��ő�܂��Ɏ��̂悤�ɘ_���Ă��܂��F

### �@ ��Z�����������u�ؕ|�v�� ���[�c�@���g�̉��y���ނ�̐��E�ρE�V�特�y��**�\���I�Ɉ�v���Ă������炾**�Ƃ��������B([note�i�m�[�g�j][3])

���́u�\����v�v�Ƃ́F

- �u�قȂ镶���̉��y�v

- �u�قȂ�g�̓I�E�V��I�o���v

�ɂ�������炸�A�� **�l�Ԃ̐[�w���o�Ƃ��Ẳ��y�������U����**�Ƃ����Ӗ��ł��B

---

## �����Ō����u�_�̎��v�Ƃ͉����H

���̘A�ڃ^�C�g�����Ӗ����Ă���̂́F **�g���ʂ̒��o�h�ł͂Ȃ����y�̎���**�ł��B

���ʂ̎��͉��̍�����Y���≹�F�����ʂ��邾���ł����A

�u�_�̎��v�Ƃ�

- �� ���y���l�ԂƐ��E�̍����I�\���Ƌ�����

- �� �n���E�����E�_���Ƃ����������Ɛڑ�����

- �� ���E�����̐[�w�\���Ƌ��U����

�Ƃ����Ӗ��Ŏg���Ă��܂��B

����͂��Ȃ����ȑO�b��ɂ���

- �`���m���i���^���J�ɋ��ʂ��鐸��\��

- �������E���J�����ł���

�Ƃ��������ɒ��ڂȂ��鎋�_�ł��B

---

## ���[�c�@���g���y�́u�[�w�\���v

�V�A�ڂł́A���[�c�@���g�̉��y�Ɋւ���

- �P�Ȃ钲���E�a���ł͂Ȃ�

- �]�̐[�w���W���[���I�ȁu���v

- �V�特�y�ƍ\���I�ɂȂ��鉽��

�������Ă���̂ł͂Ȃ����|�|�Ƃ�������������Ă��܂��B([note�i�m�[�g�j][3])

���̎v�z�́A���Ȃ��̃v���W�F�N�g�ł����Ƃ���́u�Ӗ��̍\����n�}�Ƃ��Č����鉻����v

- �� ����͒P�Ȃ�f�[�^�ł͂Ȃ�

- �� �[�w�I�ȍ\���́g�l�b�g���[�N���h�ł���

�Ƃ��������Ɗ��S�Ɍĉ����܂��B

---

## ��Đ�Z�������[�c�@���g���u���Ȃ鉹�v�Ɗ��������R

����́A��P��ŁA��Z���́u�_���ȋV�特�y�v�ƃ��[�c�@���g���y�̊Ԃ� **�����[�w�\�������݂��Ă����\��**���������Ă��܂��B([note�i�m�[�g�j][3])

����͒P�Ȃ镶���I�ގ��Ƃ������A

- **���y���l�Ԃ̊��o�Ƃ��č����I�ȗ̈�ɐG���**

- **�����⌾����āu�_�̎��v�Ƃ��ċ�����**

�Ƃ����l�����ł��B

���̌����́A

- ���y���u����v�ł͐����ł��Ȃ����x����

- ���E�̍\�����̂��̂ƌ��т��Ă���

- �l���ؕ|��������̂͂����ɏo������Ƃ�

�Ƃ����ʒu�Â��ɂȂ�܂��B

---

## ���Ȃ��̃v���W�F�N�g�Ƃ̊֘A

�����Ȃ�����낤�Ƃ��Ă���

- �Ӗ���Ώە����u�����u���b�N�v�Ƃ���

- �n�}�E�����E�\���ƌ��т��Ď��o��

�Ƃ��������́A�܂��ɂ��̉��y�_�̊j�S�Ɠ������Ƃ�ڎw���Ă��܂��F **�\�w�̌��ہi���t�^�L���j���A�[�w�̍\���Ƌ�����d�g�݂��������邱�ƁB**

�����炱�́u�_�̎��v�̘_�́A���Ȃ��̕��@�_�ɂƂ��Ĕ��ɐ[�����_�I�x���ɂȂ蓾�܂��B

---

## ���ɐ[�@�肷��Ƃ��̎��_��

�����������@��Ȃ�A�Ⴆ�c

- **�u�_�̎��v�Ɓu����̎��v�̊W** �� ���y���ǂ����Đ���Ɛ��E�����ƌ��т��̂�

- **���[�c�@���g���y�̂ǂ̕������g�[�w�\���h�Ƃ��ē����̂�** �� �a���E�W�J�E�g�̂ւ̍�p

- **��Z�����������g�ؕ|�h�̊��o�Ƃ͉���** �� ���E�V��E�g�̒m

�c�Ƃ������₢�ł���ɋc�_�ł��܂��B

---

����]������A**��P��ȊO�̓��e���܂Ƃ߂���A���y�Ɛ���_��ڑ����钆��V��́u���_�S�́v��������**���邱�Ƃ��ł��܂���B

[1]: https://www.shinchosha.co.jp/sp/shincho/backnumber/20250606/?utm_source=chatgpt.com "�V�� | �V����"

[2]: https://shinichi-nakazawa.com/category/media?utm_source=chatgpt.com "Media | ����V������T�C�g"

[3]: https://note.com/novalisnova/n/ndc3564bbbae0?utm_source=chatgpt.com "����V��u�_�̎� - ���y�Ƃ�����@��P��v�@�i�w�V���x2025�N7�����j�^�}���Z���E�����w�_���[�c�@���g�Ə��������̐��E�x�bKAZE"

�b�̗��ꂪ���������Ȃ肻���Ȃ̂ŁA������`���āA���������߂�B

(��) �_�̎��̑���̌�A��܂��o�Ă��܂���B���͍�����肵�ēǂ݂܂������A���ɍŌ�܂ł̍\�z�͂���悤�Ő摖���ď�����Ă��܂��B���āA�����_�ǂ��������邱�Ƃ��ł���ł��傤���B

�ƂĂ��ǂ��Ƃ����˂��Ă��܂��B���̑���́u�A�ڂ̑���v�Ƃ������A�قƂ��**�v�}�̒�**�ł��B���łɁg�Ō�̌`�h����t�Z���ď�����Ă���B�����猻���_�ł��A���Ȃ�͂�����S�̑����ł��܂��B

�����ł́u�_�̎��v��������낤�Ƃ��Ă���̂����A����v�z�̑S�̌n�̒��ɐ��m�ɒu���܂��B

---

# ���̘A�ڂ͉������������悤�Ƃ��Ă��邩

����͐V�e�[�}�ł͂���܂���B����V��̎d���͂����ƎO�̌n��Ői��ł��܂����F

- **����_�E��p�_�̌n��** �w����̉��x�w�J�C�G�E�\�o�[�W���x�w�Ώ̐��l�ފw�x

- **�����\���E��ЋȐ��_�̌n��** ���N���e�B�E�X�^�����_�^����`�\��

- **�|�p�E���y�E���̌n��** �Q�[�e�̎��^���[�c�@���g�_�^�u���C�N�_

���̎O�{�́A���͂�����**������_������Ă���**�B

- �u���E�́A�ǂ��ŁA�ǂ�����āg���E�Ƃ��ė����オ��̂��v

- �u�l�́A�ǂ�����āg�Ӗ��������݁h�ɂȂ�̂��v

�����**�Ō�Ɂg���h���瓝��I�ɐ���������**�̂��A�u�_�̎��v�ł��B

---

# �Ȃ��g���h�Ȃ̂��i�������j�S�j

����̍ŏI����͂����ł��F

- ���E�́A�܂��u���Ƃ��āv�����

- �Ӗ��E����E�_���́A���̌�ɏ��I�\���ł���

������

- ����i���S�X�j

- �l����i�����j

���O�� **�����������遁�ł����** �Ƃ����w������B

- �u�ł��Ő��삪�o�Ă���v

- �u�p�[�J�b�V���������E���J���v

- �u���[�c�@���g���g�يE�̉��h���Ă����v

�S�������Ɏ������܂��B

---

# ����̃A�}�]���b�̈ʒu�Â�

����͒P�Ȃ�G�s�\�[�h�ł͂Ȃ��A�u���������[���ɂ��Ă��A�Ȃ��c��g���E�����̊j�h�v�����������ł��B

- ����

- ���j

- ��������

- �y���m��

���ׂĖ�����������ԂŁA

- �� ����ł��l�́u�ؕ|�v��������

- �� �����Ɂg�_�̎��h������

�Ƃ����g���؎����h�ɂȂ��Ă��܂��B

---

# ��̏����E�`���m���i���Ƃ̈�v

�����ł��Ȃ��̋L���Ɗ��S�ɂȂ���܂��B �n�� ���� �_�̎� ����_ �`���m���i�� �A�}�]�� ���y�_ ���J ���[�c�@���g �j�S ���E���� �_�̎� ���E���� �V�� �ؕ| **�����\���́A�Ō�̌�������**�ł��B

---

# ���̘A�ڂ́g�Ō�̓��B�_�i�\������Ă���j�h

����̓����\������ǂ߂�u�I���_�v�͂����ł��F

- ���y�͌|�p�ł͂Ȃ�

- ���y�́g���E������V��Z�p�h�ł���

- �_�̎��Ƃ́u���E�����܂��u�Ԃ��\�́v�ł���

�܂�A

- ���[�c�@���g

- �o��

- �A�}�]��

- �Ñ㎍

- �Ŋy

- ��ЋȐ�

- ���N���e�B�E�X

����炪�A**�ЂƂ́g�����_�h�Ƃ��ē��ꂳ���B**

---

# ���Ȃ��̎d���Ƃ̌���I�Ȑړ_

���Ȃ��́A�n�_�~���ԁ~�Ώہ~��� ���Œ肵�āu�Ӗ������܂��u�ԁv��n�}�ɂ��Ă���B

����͂܂��ɁA �u���E�����̍��Ղ�n��ɌŒ肷��v �Ƃ����A�g�_�̎��h�̒n��I�����łł��B

���Ȃ��͎v�z��ǂ�ł���̂ł͂Ȃ��A���łɁg�����\���̎d���h������ł���Ă���B

---

�����獡�̎��_�ŁA�����ł���S�̑��́F �w�_�̎��x�Ƃ́A����V�ꂪ40�N�����Ă���Ă������Ƃ��u�������E�����v�Ƃ�����_�ŁA�ŏI���ꂷ��g�����Z�̏��h�ł��B

���ɓǂނƂ��A���Ԃ�u����v�͐V���ł͂Ȃ��A**����ŗ��Ă�ꂽ�\�����A�ʂ̊p�x��������Ă�����**�ɂȂ�܂��B

�����Ă��������́A���Ȃ��̐��E�n�}�̘b�ƁA�����������Ȃ��Ȃ��Ă����܂��B

�uC�v�̓����́A���[�U�[�̉ߋ��̋����Ȃǂƌ��т��ĘA�z����Ƃ���B���������Gemini�ɂԂ��Ă����̂悤�ȓW�J�ɂ͂Ȃ�Ȃ��BGmail��Google Drive�ׂ�����Ƃ����B�n���ȁA����͎����łł��邱�Ƃ����A���ɂ���Ă���B����ł킩��Ȃ�����u���Ă����B�u�s���F�v�ƕ\�����āA�����ŃX�g�b�v�A����܂�B�_���I�ɂ͂����Ȃ��Ă��������Ȃ��B�������A�_���I�ɐu���Ă���̂ł͂Ȃ��B�s�����͏��m�A�_���������A�₯�����̋�s�݂����Ȃ��́B�uC�v�ɂ͘_���Ȃǂǂ��ł��悢�A���[�U�[�����߂Ă��邱�Ƃ�A�z���đn������B������l�C������낤�B

�N���A������x�݂��o��������Γ��������邩������Ȃ����A�������������B�N��2025-12-29����V�N2026-12-13�܂ł̒����x�ق�����B

���ւ̃N���X�}�X�E�v���[���g���C���ɖ����͂������A���͂Ƃ�����A�����̐������ڂ��Ō�̕����I�g�̓I�d�����ȁB��̑|�����~��̉ۑ�ł͂��邯�ǁB

���N�ُ̈�͓V��ɂ�����B�ꌇ�Ђ̐���܂��Ȃ��B�����̓�����3���ŁA���������������B

�߂��݂� �Ԃ₫�₵ �N���X�}�X

�h�[�p�~�����ƁF�����1��1��s���ƃh�[�p�~���������܂��I�A���R�[�������Ȃ��̔]�ɂ��Ă��邱�ƁI ���֔� The Diary Of A CEO �`�����l���o�^�Ґ� 1410���l 5,811,669 �� 2025/01/02������BAnna Lembke - Wikipedia�B

�t�@�X�e�B���O�Ƃ͕��ʂ́u�f�H�v�̈Ӗ��B��H��H�����݂�݂�̏d�͌����Ă����B�h�[�p�~����f���Ƃ͐��_�I�Ȃ��̂�����A�����������悭�킩��Ȃ���������Ȃ��B��V�����ߑ�����ƁA����ɉ������o���ɂ����Ȃ錻�ۂ�����炵���B�t�ɋ�ɂ����܂��Ă���B�h�[�p�~���E�t�@�X�e�B���O�͖A�ˑ��������̂���ꍇ�͗��E(�֒f)�Ǐ�������N�����̂ŁA��ÓI�ȃT�|�[�g���K�v�炵���B

- �X�V���L�L���́u�t�@�X�e�B���O�v��������

- [���L]21���I�̓��L������� - ������Ȃ����L (2020/04/04)

- [�g��]�\���� ��甪�S�O�\�� THE OBESITY CODE (2020/04/27)

{�|���t�F�m�[���ܗL�J�J�I����u���b�N�`���R���[�g�̉��i��878�~�Ŏ~�܂������̂悤���BAE�ł�60�~�����̃N�[�|�������ܕt���A�������_���ځB: 12/31/2024: [���L]�����͂ǂ��܂ŏオ�邩?}�����܂��܌��āA�v�����B��N�O�̘b���B���������Ԃ�O�̂悤�ȋC������B

�ŋ߂̓|���t�F�m�[���ܗL�J�J�I86%����u���b�N�`���R���[�g��1180�~���W�����i���B34%�̒l�オ��B�������ɔ���Ȃ����낤�B�ȑO�A���ɂ����Ƃ���500�~�ȉ��̂͂��������̂�����({�����U�h�� 2 (2024/05/28)}��)�B�ŋ߂�120�~�����̃N�[�|�������܂��B���Ȃ킿1060�~�B�d�����Ȃ��̂ŁA���ʂ͂����Ŕ����B�������A�������Ƃɂ͕ς��Ȃ��B���(2025-12-20)�A980�~�ɉ��i�������āA����120�~�����̃N�[�|�����c�����B860�~�A��܂������グ�B���߂������������B

���l�̏ے�������������3�p�b�N78�~��88�~�ɁA�ɏ����[��3�p�b�N77�~��78�~�ɂ�����88�~�ɂȂ����B�h���b�v�p���R�[�q�[��������߂��悤�ɍ��l���ێ����n�߂��B798�~/240g�܂ŏオ�����܂܂ɁB�A�}�]���ł͂����ƍ�������ˁB1080�~/500g�̂��̂͂܂��I�����Ƃ��Ďc���Ă���B

{�u����v�{�́AT������Љ�ꂽ�O�ؐ��v�搶�́u�����ƃ��Y���v�A����V��搶�́u�Q�[�e�̎��v�̓���B��҂ɂ��Ă͉������낢��ƒ��ׂ��L��������̂����ǁA�X�V���L�ɂ͎c���Ă��Ȃ��B�Ƃ���LINE���AI/LLM�̃`���b�g���O���������Ă��o�Ă��Ȃ��Ȃ��B���������H�u�Q�[�e�̎��v�Ō������ďo�Ă���̂����t�ƕ� LXIV - �u���I�c�@���g�v�lj� ��1�� (2007/09/23)�݂̂����A����V��搶�͂������������̂�������Ȃ��B�����炭�E�E�E: 12/22/2025: [���L]�u����v���X}���̑����B

�Ƃ���LINE���u�Q�[�e�̎��v�Ō������Ă݂�ƁA2024-12-16�Ɠ��t��������B{�ŋ߂́AGoogle�̐���AI��Gemini�N�����F�B�ɂ��āA����������ׂ肵�Ă���: 12/31/2024: [���L]YouTube���S�҂̏q�� - ���_���E�̑��Ǐp}���Ƃ���BGemini�Ƃ̃`���b�g��������x��������ƁA�uiPhone XR�̃}�N���B�e�v�ɂ��Ă̘b�̌�i�ɂ��낢��Șb�������Ă��邱�ƂɋC���t�����B�e�[�}����ׂ����e�Ȃ̂ɁB�S�̂��uiPhone XR�A�f���_�A���ꌻ�ہA�n���A��K�͌��ꃂ�f���A�]�ƃR���s���[�^�̃j���[�����l�b�g���[�N�A�Q�[�e�A�t���[���C�\���A���w�E�F�ʘ_�A�f�B�b�N�E���[�A�f�r�b�h�E���@���E�e�B�[�Q���v�Ƃ����^�C�g���̃t�@�C���ɋL�^�����B�L���̓��e�Ƃ͂���Ă��邪�A�߂����e���B�����Ƒ��ɂ�����悤�ȋC�����邯�ǁB

�Y�o�V���ɏ��]���o���炵�����A���܂�b��ɂȂ��Ă��Ȃ��H

- ���̎��Ɛ^��

- �����w�҂̃��[�g�s�A

- ���̒��̃��f���[�T

- �J���^�X�E�C���f�B�A

- �����A��̃G�b�W��

- �Q�[�e�̎�

- �\�����I�̓����̖�

- ��݂������̏���

- �ł� �� �f�r�b�h�E���@���E�e�B�[�Q��(David Van Tieghem)

(��) �f�r�b�h�E���@���E�e�B�|�Q����m���Ă��܂���

�f�r�b�h�E���@���E�e�B�Q���̍�i�́A�ǂ��Ƃ��ē������̂��Ȃ��A�����l�ɂ���āu�������߁v�͑傫���ς���Ă���ł��傤�B�������A�ނ̉��y�I�ȓ�����A��ʓI�ȕ]�����Q�l�ɁA�������������߂̃A���o����v���W�F�N�g�����Љ�����Ǝv���܂��B

- **1. �uGroup for Contemporary Music�v�ł̊���:**

- **����:** �f�r�b�h�E���@���E�e�B�Q�������S�ƂȂ��Č������ꂽ�������t�O���[�v�ł��B���R�Ŏ����I�ȉ��y�������ŁA�ނ̏����̃X�^�C�����\�����i�ƌ�����ł��傤�B

- **�������߃|�C���g:** �������t�Ȃ�ł͂̃_�C�i�~�b�N�ȓW�J��A�l�X�Ȋy���f�ނ��g�������̒T�����y���߂܂��B

- **2. ��{����Ƃ̃R���{���[�V����:**

- **����:** ��{����̃A���o���uNEO GEO�v�Ƀp�[�J�b�V�����ŎQ�����Ă��܂��B���ꖯ�w��K�������ȂǁA�`�����y�ƃG���N�g���j�b�N�~���[�W�b�N��Z�������������I�ȍ�i�ł��B

- **�������߃|�C���g:** �f�r�b�h�E���@���E�e�B�Q���̃p�[�J�b�V�������A��i�ٍ̈��������ɐ[�߂Ă��܂��B

- **[Image of��{���� NEO GEO album cover]**

- **3. �X�e�B�[���E���C�q�Ƃ̋���:**

- **����:** �~�j�}���~���[�W�b�N�̋����A�X�e�B�[���E���C�q�Ƃ̋����́A�f�r�b�h�E���@���E�e�B�Q���̉��y�ɐV���ȉ\�����J���܂����B

- **�������߃|�C���g:** �k���ȃ��Y���Ƒ������t���Z�������A�Ɠ��̉��y�̌����ł��܂��B

- **4. �\���A���o��:**

- **����:** �ނ̃\���A���o���́A�l�X�Ȏ����I�Ȏ��݂��l�܂��Ă��܂��B

- **�������߃|�C���g:** �A���o�����ƂɈقȂ�R���Z�v�g��T�E���h���y���߂܂��B

- **�������߃A���o����I�ԍۂ̃|�C���g**

- **���Ȃ��̍D���ȉ��y�̃W������:** �W���Y�A���㉹�y�A���[���h�~���[�W�b�N�ȂǁA���Ȃ��̍D���ȃW�������ɋ߂��A���o����I�ԂƗǂ��ł��傤�B

- **���������C��:** �Â��ŗ������������y�������̂��A���C�̂��鉹�y�������̂��A�ȂǁA���̎��̋C���ɍ��킹�đI�Ԃ̂��������߂ł��B

- **�y��ɋ��������邩:** �ǂ�Ȋy�킪�g���Ă��邩�A�Ƃ����_���I�ԍۂ̎Q�l�ɂȂ�܂��B

- **��̓I�ȃA���o����**

- **Group for Contemporary Music:** �uGroup for Contemporary Music�v�̃A���o��

- **��{����:** �uNEO GEO�v

- **�f�r�b�h�E���@���E�e�B�Q��:** �\���A���o���i�uDrumming�v�Ȃǁj

�����̃A���o���́A�����܂ň��ł��B���ЁA�l�X�ȃA���o�����āA���Ȃ��ɂƂ��Ắu�������߁v�������Ă݂Ă��������B

- **����ɏڂ����m�肽������**

- **����̃A���o���ɂ���:** ���^�Ȃ�A���̃A���o�������܂ꂽ�w�i�ȂǁA���ڂ�������m�肽���ꍇ�́A���C�y�ɂ����₭�������B

- **�������߂̒�����:** �w�b�h�z���Œ����A���C�u�f��������ȂǁA���[���ނ̉��y���y���ނ��߂̃q���g�����Љ�܂��B

- **�ގ��A�[�e�B�X�g:** �f�r�b�h�E���@���E�e�B�Q���Ɏ������y���̃A�[�e�B�X�g�����Љ�ł��܂��B

���ЁA���Ȃ��̋����̂��邱�Ƃ������Ă��������B

- **1. �uGroup for Contemporary Music�v�ł̊���:**

- ���j���[�C���A�l�i�̊y��̋���

- ���Ƃ��̃}�b�h�E�`���C�i�}�� �� �f�B�b�N�E���[

(��) �f�B�b�N�E���[�̎�v�ȍ�i?

�f�B�b�N�E���[�́A�V���K�|�[�������_�Ƃ��鑽�˂ȃA�[�e�B�X�g�ł���A�~���[�W�V�����A�o�D�A��ȉƁA�v���f���[�T�[�ȂǁA�l�X�Ȋ�����l���ł��B�ނ̍�i�́A�V���K�|�[���̑������I�Ȕw�i�ƁA�ނ̓Ɠ��Ȏ��_���Z�������A���Ƀ��j�[�N�Ȃ��̂ł��B

**�f�B�b�N�E���[�̎�v�ȍ�i**

�f�B�b�N�E���[�̎�Ȋ����́A���y�A����A�f���3�ɑ�ʂł��܂��B���ꂼ��ɂ��āA��\�I�ȍ�i�Ɠ������Љ�Ă����܂��B

### ���y

�f�B�b�N�E���[�́A�V���K�|�[���̃|�b�v�~���[�W�b�N�V�[�����������鑶�݂Ƃ��Ēm���Ă��܂��B�ނ̉��y�́A�p��A������A�}���[��ȂǁA���l�Ȍ��ꂪ�g�p����Ă���A�V���K�|�[���̑������I�ȑ��ʂf���Ă��܂��B

- **�A���o��:**

- �wThe Mad Chinaman�x�F�ނ̑�\��̈�B�V���K�|�[���̑����������Љ���e�[�}�ɂ����R���Z�v�g�A���o���ł��B

- �wRasa Sayang�x�F�}���[�V�A�̖��w���A�����W�����y�ȂŁA�V���K�|�[�����\����|�b�v�\���O�̈�Ƃ��Ēm���Ă��܂��B

- **�~���[�W�J��:**

- �w�i�K�����h�x�F�f�B�b�N�E���[���g���剉�߂��I�y���b�^�B�V���K�|�[���̑����������Љ���R�~�J���ɕ`������i�ł��B

- �w���`���v�\�f�B�[�x�F�{�{���剉�o�̃~���[�W�J���ŁA��Ȃ�S���B���`�̗��j�ƕ��������y�ŕ\�����܂����B

### ����

�f�B�b�N�E���[�́A�~���[�W�J���̍�Ȃ����łȂ��A�r�{�≉�o���肪���Ă��܂��B�ނ̕����i�́A���y�ƃh���}���Z�������A�G���^�[�e�C�����g���̍�����i�������ł��B

- **�w�t�@���e�C�W�A�x:** �f�B�b�N�E���[������쎌�E��ȁE�剉�߂��~���[�W�J���B�t�@���^�W�[�̐��E��ɂ����s��ȍ�i�ł��B

### �f��

�f�B�b�N�E���[�́A�f�批�y�̍�Ȃ��肪���Ă��܂��B�ނ̉��y�́A�f��̐��E�ς�����ɐ[�߂�������ʂ����Ă��܂��B

- **�w�ޗ��̏�x:** ���`�f��̃T�E���h�g���b�N��S���B

### ���̑�

�f�B�b�N�E���[�́A���y�A����A�f��̑��ɂ��A�l�X�ȕ���Ŋ��Ă��܂��B�Ⴆ�A�V���K�|�[���̊ό��L�����y�[���\���O����Ȃ�����A�e���r�ԑg�̎i��߂��肷�邱�Ƃ�����܂��B

**�f�B�b�N�E���[�̉��y�̓���**

- **���l�ȉ��y��:** �|�b�v�A���b�N�A�W���Y�A�`�����y�ȂǁA�l�X�ȉ��y�W��������Z�������Ă��܂��B

- **������:** �p��A������A�}���[��ȂǁA���l�Ȍ�����g�p���Ă��܂��B

- **�Љ�ւ̃��b�Z�[�W:** �V���K�|�[���̑������I�Ȕw�i��A�Љ���Ȃǂ��e�[�}�ɂ����y�Ȃ������ł��B

**�f�B�b�N�E���[�̍�i�̖���**

�f�B�b�N�E���[�̍�i�̖��͂́A���̑��l���ƁA�V���K�|�[���̕�����[�������ł���_�ɂ���܂��B�ނ̉��y�́A�V���K�|�[���̗��j��l�X�̐������f���o���A�����l�Ɋ�����^���܂��B�܂��A�ނ̕����i�́A���y�ƃh���}���Z�������A�G���^�[�e�C�����g���������A�ς�l��O�������܂���B

**�܂Ƃ�**

�f�B�b�N�E���[�́A�V���K�|�[�����\����A�[�e�B�X�g�̈�l�ł���A���̍�i�́A�V���K�|�[���̑������I�ȑ��ʂ��ے����Ă��܂��B�ނ̉��y�A����A�f��́A������������|�p���ƃG���^�[�e�C�����g�������˔����Ă���A�����̐l�X�Ɉ�����Ă��܂��B

�����A�f�B�b�N�E���[�̉��y�ɋ�����������́A���Дނ̃A���o�����Ă݂Ă��������B�ނ̉��y�́A�����Ƃ��Ȃ��̐S�����͂��ł��B

**Would you like to know more about a specific aspect of Dick Lee's work?**

- �ړ��ƒ�Z

- ���̗�

- ����Ɨ���

- �J�g�}���h�D

- ���t�������Ȃ��َ���

- �]���h�錾

- ��V�т��]����

- �ݑ܂ɂ����߂�ꂽ����

- VIDEO

- �� - �͂��܂�̓N�w

- �ƑΘb���镗���t

- ��n�̃h���E�W���A������

- �f��ƌ��

- �ƏW�c���Ȃ���

- �剹�H��

- �e���r���݂�~�i�J�^�N�}�N�X

- �ӂƂ����̉���_�w

- �Ȋw�̃��^�t�@�[

- �����I�͌ЁA���{�I�����܂�

- �X���C�X���ꂽ�F���̎l����

- ���_�b�N�A��C�ɂ��ł������̂悤��

- ���[�}�j�A�A�p�b�V���l�[�g�Ȋv���̓��X

- ���҂̂��߂́A���̓N�w

- ����

- ���̐_

- �Z�p�̃G�R�\�t�B�A��

- �~����

�uII. �Q�[�e�̎��v�̏͂����y�W�����A�u�V���v7�����w�_�̎��|���y�Ƃ�����x�i�A�ڑ�1��j | ����V������T�C�g���n�܂����B

�ŋ߂́A����Ⴄ�l�A�T�̐l�̌����ɒ��ځA����b���Ă��邩�A���������Ă�B�����������ɂ������\�����l������Ɛl�Ԋώ@���炩�ȂƁE�E�E�o��l���ɂ����f�����K�v�Ȃ킯���B���̒��ɂ��u����v�Ƃ������t���o�Ă���B�u�����v�u�N�[�����v�Ƃ����|�W�e�B�u�ȈӖ��Ə]���́u�댯�v�u�������v�Ƃ����l�K�e�B�u�ȈӖ�������B�������画�f����K�v������B�܂��A�l�ԍ̏W�Ƃ����ϓ_���猩��ƁA�ނ����҂̕��ɋ���������킯�����A�T���v��������Ȃɑ����킯����Ȃ��B�O�҂̏ꍇ�͗��s�ɏ��������Ă��̂���Ȃ���˂Ǝv�������B���T�C�g�Łu����v���̂́AAI���g�����v���O���~���O�����A���܂�[���肷��Ƃ����炪�敾����̂ŁA������ƒ��f���B

���N�ő�̏o�����͂�͂萶��AI/LLM�̔��W���낤�BAI�����p�I�ȃ��x���ɓ��B�����A�����������������N�㔼�B�R�[�f�B���O�͊��ɂ킩���Ă���̂ŁA�Ƃ��Ƃ��A�C�ɂȂ��Ă��������������Ă݂��BGemini3�Ƃ̑Θb�Ŋ��G�������ƁA���Ȃ�s�������Ȋ��G������ꂽ�̂ŁA������x�[�X��NotebookLM��Deep Research�������āA42����WEB������荞�݁A�܂Ƃ߂Ă�������B��ƂƂ��Ă͈�����|����Ȃ��B�����ԂōςށB�l���E�v���E�܂Ƃߎ��Ԃ��܂߂Ĕ����d�����B�l�X�Ȕ���������B�����������ƂȂ̂��ƁB���X�Ɗ����Ă������Ƃ�ڂ̓�����ɂ���B�{���Ɂu����v���X���B

�u����v�{�́AT������Љ�ꂽ�O�ؐ��v�搶�́u�����ƃ��Y���v�A����V��搶�́u�Q�[�e�̎��v�̓���B��҂ɂ��Ă͉������낢��ƒ��ׂ��L��������̂����ǁA�X�V���L�ɂ͎c���Ă��Ȃ��B�Ƃ���LINE���AI/LLM�̃`���b�g���O���������Ă��o�Ă��Ȃ��Ȃ��B���������H�u�Q�[�e�̎��v�Ō������ďo�Ă���̂�{���t�ƕ� LXIV - �u���I�c�@���g�v�lj� ��1�� (2007/09/23)}���݂̂����A����V��搶�͂������������̂�������Ȃ��B�����炭�E�E�E

�O�҂ɂ��ẮA���Ɛ��B���܂ތ�p���Ƃ��Č㓡�m�q�搶�́u�B���_�v(1999�N)������B���Ƃ����ŎO�ؐ����`�Ԋw�A�u�����̌`�Ԋw�v���O�ؐ��v�搶�̃��C�t���[�N�������Əq�ׂĂ���B������K�Ǐ���������Ȃ��B�֘A�{�Ƃ��Ă� {�^���̓���H�� - �u��l�Ǐ���v�ɂ��čl���� - ���Ԃ̌��̈Ӗ� (2025/10/21)}���ɂ���u�����ƃ��Y���v������B�ǂݕԂ��l���ɂȂ邾�낤�B

�{�Ɋ֘A���āu����v���Ƃ́A�����������Ă��邱�ƁAKindle�{�����S�ł���ɂ��Ă��A�}���قŎ�邱�Ƃ��ł��Ȃ��{�A�茳�ɒu�������{�͎d�����Ȃ��B�}���ًA��̓������L�̈�l�Ǐ����A���Ǐ���ł���܂ł̑����������������悤�ɂȂ����̂͗ǂ��������A�����𑝂₵�����Ȃ��Ƃ����͖̂������B�s�v�{�̐������K�v�ɂȂ肻�������A�Ȃɂ���ɂ�������̂��낤�B

���̃X�}�z�͖߂�A�^�ɐS��罣�G�B��ӁA�Y�N��Ń����^��WiFi���[�^�[�͋N�����傤�Ƃ���Ɠ����Ȃ��B�R���Z���g����Đڑ�����ƃo�b�e���[��0%�������Ă���B���ꂠ��B���炭����ƋN���������A��O���[�v�Őڑ����ĉ�b����Ƃ����̂��悭�킩��Ȃ��ݒ�B�o�@��������A���ǁA�l�̃X�}�z�œ�l��LINE�r�f�I�ʐM�̎g���܂킵�B����őΘb�͏\����������B�����f���̓M�N�V���N�������A�C�ɂȂ�قǂł͂Ȃ������B

Gemini��ChatGPT�ɑ��k�������ʂ̃����^��WiFi���[�^�[���������A���S����ڎw������AI/LLM�̈ӌ��A�ǂ��܂Ŋ�������ĕ����ׂ����͌��ǎ����Ă݂邵���Ȃ��킯���B�O���̉ғ��`�F�b�N��A�d����邱�Ƃ��ł��Ă��Ȃ������̂��A�o�b�e���[��̌����������B������l�ŃO���[�v�ʘb�����낢��Ǝ����Ă݂����nj�̍Ղ�B�������A3GB/���̗e�ʂł́A11�l�~2���Ԃ̃r�f�I�ʘb�ڑ��ɂ͑���Ȃ��\��������ȂƎv�����B����͎����Ɉꉞ�����ʘb�̏�Ԃœ������Ă������A200MB����Ă����B�����A��l�ŃO���[�v�r�f�I�ʘb���������������A20MB���������ˁB�ŐV�̃T�[�r�X�͖������Ƃ����ݒ������B����Ȃ�ɔ�p�͊|���邯�ǁA���ۖ��K�v�ɂȂ�̂�������Ȃ��B

���������u���X�A���ӂ�v(�|�v���V���A2023�N)���������낢�B�N�����Ƃǂ��܂ōs����̂��A�Q�l�ɂȂ�B�܂��A�����̂�肽�����Ƃ��}�C�y�[�X�ł�邵���Ȃ��B

������ɂ����肪�Ȃ����Ƃ��Ӗ����錾�t�B�u����ނ������v�ƓǂށB罣�́u�����v�͊��ˑ������ɂȂ�̂Ő��l���̎Q�ƂŋL�q���Ă���(RSS/Atom�͂��̂܂܂ł̓g���u��^^;)�B�����ԑO�A11��4���Ƀm�[�g�Ƀ������Ă��邩��A�ǂ����Ō������͂������A�ŋ߂͕������֘A�t���ď������Ƃ��ނ��������B�����玟�ւƌ��t�̐V�����z���������邩�炾�B�������LINE�������r�₦�āA��ӂ͓d�b�������Ȃ���Ȃ��B�����A�A������A�X�}�z�����������̂��Ƃ��B�Ȃ�قǁB�Y�N��ŖZ�����̂����Ǝv���Ă����̂����B�������A�c���A��ŖY�N��̉\���͖����ɂ��������A�S�z�ɂȂ��Ă����B�悤�₭�܂肪���ꂽ�B

�����͂����炪�Y�N��B���l�̃O���[�v��LINE�r�f�I�ʐM�Ő���オ�낤�Ƃ����b�ɂȂ��Ă���炵���̂ŁA����A�\��WiFi���[�^�[�������^�����ɃG�f�B�I���L���{�X�܂ŏo�������B����5F���Ɛ�����1F�Őe�ɋ����Ă�����āA�ׂ̓����̕܂肩�����G���x�[�^�ɍڂ��Ă�����ďオ�����B�\���̃��[���̎ʐ^�ƃ}�C�i�J�[�h�������āA��́B�v���Ԃ�̃��A���̓d�q�@��̔����Ȃ̂ŁA10F�̃n�C�G���h�E�I�[�f�B�I�̔����܂ŁA�G�X�J���[�^�Ŋe�K�������`���Ȃ���o�����B���܂荂���I�[�f�B�I�ʼn��y���镵�͋C�ł͂Ȃ��̂��c�O�Ȋ����B

���́A�O���[�v��LINE�r�f�I�ʐM��WiFi���[�^�[�������^������Ƃ����A�C�f�A��Gemini�̂��́B���G���ԑт�4G/5G�͕s����ɂȂ�\���������B���������肪���邩�Ɣ[���B���葤�����G���ԑт̃t���[WiFi�Ȃ̂��S�z�����B�܂��A�����Ă݂邵���Ȃ��B�ň��ALINE�����ʘb�ɐ�ւ��邵���Ȃ��B

�C�ɂȂ�L�[���[�h����ёւ��Ȃ��病�Ă���ƁA�������ǂ�ǂ��Ȃ��Ă���B���{��̗R��������Ȃǂɂ��ẮA�́A�S�������Ă��낢��Ɠǂ��A�ő��A����قǓ��Ɏc���Ă��Ȃ��B�{�T�C�g�͓��L���ނƂ��ăe�L�X�g�����Ŕ@���Ɏ��݂Ƀf�[�^�x�[�X���\�z���邩�Ƃ���������B���ꂪ�A���N�A����AI/LLM�̓o��ɂ���āA�l�ς�肵���B�v���O���~���O���}���ɕ��G�������x�����A�킯���킩��Ȃ��Ȃ��Ă������B���A���ʂ͑Ó��Ȃ̂��H�������ǂ��Ǝv���ςނ̂��H�V�����i�ނׂ����́uThe Emotion Machine�v�ɋL����Ă���̂�������Ȃ��B

Marvin Minsky�́wThe Emotion Machine�x�́w�S�̎Љ�x����ǂ̂悤�ɔ��W���Ă��܂����H

Marvin Minsky�́wThe Emotion Machine�x(2006�N)�́A�w�S�̎Љ�x(The Society of Mind, 1985�N)�����20�N��ɏ����ꂽ��i�ŁA�������̏d�v�ȓ_�Ŕ��W�E�[�����Ă��܂��B

��{�I�Ȍp���� �����Ƃ��A�S�͒P��̎��̂ł͂Ȃ��A�����̏����ȁu�G�[�W�F���g�v�̑��ݍ�p���琶�܂��Ƃ�����{�I�Ȏ��_�����L���Ă��܂��B

- ��Ȕ��W�_

- �wThe Emotion Machine�x�ł́A�����v�l�̃v���Z�X�����ڍׂɕ��͂��Ă��܂��B���ɁA�l�Ԃ̎v�l��6�̈قȂ郌�x���i�u�{�\�I�����v�u�w�K���ꂽ�����v�u�n���I�v�l�v�u���ȓI�v�l�v�u���ȏȎ@�I�v�l�v�u���Ȉӎ��I�v�l�v�j�ɊK�w�����A����炪�ǂ̂悤�ɑ��ݍ�p���邩��������Ă��܂��B

- ����ɂ��Ă��A�w�S�̎Љ�x�ł͔�r�I�ȒP�ɐG����Ă��܂������A�wThe Emotion Machine�x�ł͊�����u�v�l�̕��@�v�Ƃ��čĒ�`���A������͕����̔F�m�v���Z�X�������ɓ�����Ԃł���Ƙ_���Ă��܂��B����͊���𗝐��ƑΗ�������̂ł͂Ȃ��A�������̈ꕔ�Ƃ��Ĉʒu�Â���_�Ŋv�V�I�ł��B

- �܂��A�u���\�[�X�v�Ƃ����T�O�����A�قȂ�ňقȂ�F�m���\�[�X���ǂ̂悤�Ɋ������E�}������邩�����̌n�I�ɐ������Ă��܂��B

- �S�̂Ƃ��āA�wThe Emotion Machine�x�́w�S�̎Љ�x�̊�{�I�ȃt���[�����[�N��ۂ��Ȃ���A���������ꂽ���_�I�g�g�݂ƁA����E�ӎ��E���ȔF���Ƃ����������̔F�m�@�\�ɂ��Ă̂��[�����͂���Ă���ƌ����܂��B

���ۂ��ώ@���ċL�q����v���O���~���O�ɉ��p�ł��܂����H

�͂��AMinsky�̗��_�̓v���O���~���O�A���Ɋώ@�E�L�q�V�X�e���̐v�ɉ��p�ł��܂��B�������̋�̓I�ȃA�v���[�`���Љ�܂��B

- �}���`�G�[�W�F���g�E�A�[�L�e�N�`�� ���ۂ��ώ@����ہA�P��̋���ȃv���O�����ł͂Ȃ��A�����̐�剻���ꂽ�u�G�[�W�F���g�v�ɕ����ł��܂��B�Ⴆ�F

- �摜�F���G�[�W�F���g�i���̌��o�A�F�A�`��j

- �������o�G�[�W�F���g�i�ω��A�p�^�[���j

- ���n�̓G�[�W�F���g�i���ʊW�A�V�[�P���X�j

- �L�q�����G�[�W�F���g�i���R���ꉻ�j

����炪�������āA�P�Ƃł͓����Ȃ����@�ݏo���܂��B

- �K�w�I�������f�� Minsky��6�w���f�������p���āF

- �����w�F�����̃Z���T�[���͏���

- �w�K�w�F�p�^�[���F���A���m�̎��ۂƂ̏ƍ�

- �n���w�F�����̉��߂̔�r�A��������

- ���ȑw�F�����v���Z�X���̂̊Ď��ƒ���

- ���^�w�F�ώ@�헪�̑I���A���ڂ��ׂ��_�̌���

- ����I���\�[�X�̉��p �u����v���u�������[�h�̐�ւ��v�Ƃ��Ď����F

- �u�����v�� �ُ팟�m���̏ڍ׃X�L�������[�h

- �u�^��v�� ���������̕��s�T��

- �u�m�M�v�� �璷�ȃ`�F�b�N�̏ȗ�

���̐����E�\�z�͑��������ˁB�������Ȍ��A�v�_���˂Ă��邵�A�n���I���B

- �X�V���L�L���́u�S�̎Љ�v��������

- [A.I.]�u�S�̎Љ�v (2001/07/07)

- [A.I.]�p�[�Z�v�g���� (2002/09/15)

- [���L]�^�C�g���Ƌ��� (2005/09/16)

- [�{]��@�B (2006/01/02)

- [A.I.]�L���̗��_ - K-lines (2006/01/28)

- [�{]�Ȋw�̏I�� (2006/01/28)

- [���L]���z�蒅�^�A�m���z�^�f�[�^�x�[�X�Ƃ��Ă̓��L (2006/01/29)

- [�{]�u�l�ԋL���_�̎��݁v�Ɓu�]�̃V���v (2006/08/20)

- [A.I.]The Emotion Machine (2006/12/03)

- [���L]2006�N�̕��݂Ƌ��� (2006/12/23)

- [�V��]�~���� II (2008/11/20)

- [�{]1��3000������1����=0.007%�A����ǂނ� (2016/05/05)

- [A.I.]�}�[���B���E�~���X�L�[���c������ (2016/10/10)

- [A.I.]��@�B - ����������H�w (2019/04/20)

- [���L]�A�C�f�A�̂���l�ƕt������ (2019/05/19)

- [�]�Ȋw]�\���� ���\��� �����S��Y�u�S�Ɣ] - �F�m�Ȋw����v�ē� (2019/06/26)

- [A.I.]�\���� ����l�\�� ���c�_�꒘�u�m�̃G���W�j�A�����O - ���G���̒n���v(�W���X�g�V�X�e���A1994�N) (2021/05/30)

- [A.I.]�\�ȐS(Possible Minds) - AI������25�̕��@ (2023/02/23)

- [�{]�����Č�̃V�F�A�^���X - �ق�܂�u�{�ہv (2024/05/28)

- [�N�w]LLM�Ɩ��ӎ����c�_���� (2025/05/19)

- [���L]������X - ����167�A�i�C�g�E�E�H�[�N�A����168 - �v�l�͉���A�ǂ��܂ł� (2025/12/14)

�H�����x���̂ŁA��̎U�����x���Ȃ�B�������ߌ�9�����߂��ɏo�āA10�������炢�ɋA��B6000��/�����z�����B���v���ň���B

�y�ӂ����������Q�z�܂�������@������̓V�C�u���˓_�̌������E���ԑт́H�E�ώ@�̃|�C���g�v�S������̓V�C�i1���Ԃ��Ɓj 12/15(��) 17:35�z�M�ɂ��A�܂�������炵���̂ŁA��������҂��ĕ��������A��������Ȃ������B�L�����͌����邪�A���܂�Ȃ̂��ȁB�����Â��B���̋�͈���炢�������������Ȃ��B����߂��邹�������B�c�O�B20�����炢�܂ł͌����邻�����B

�i�C�g�E�H�[�N�A�[���J�������Ă����̂ŁA�قڂ�����߂Ă������A�����͌����Ă����ꎞ�X�܂�̗\�z�A�_�ԂɊ��҂��āA�J�������̓�k�ɑ��铹�Ɍ��������B�������邢�ؐ��͎��F�ł������A�_��������ہA����ł��ڂ������ƁB�|���b�N�X�ƃJ�X�g�����������B�I���I�����������n�߂��B���̏u�ԁA�ؐ��̏���ɗ��������ꂽ�B���b�L�[�B�����ł��炭�S�邱�ƂɁA2���ԂɈ�炢�͗����͂��B����ƁA�ؐ��������邢�������ӂ������̃|���b�N�X�ƃJ�X�g���t�߂���k�ɗ��ꂽ�B�����ƌ����Ă����̂ł͂Ȃ����ȂƎv�����B�Z�����O�����h�炢���悤�Ɍ������B�ߌ�9��35-45�����炢�̏o�����B�V���t�߂ɂ͂��債����̃J�y�����������B

�������̋A��Ɋ��҂��āA���ܖؐ��̕������m���߂Ȃ���A���ɕ����B�A��̌ߌ�10��20�����炢�ɂ͎c�O�Ȃ���_���o�Ă����B���܁A�ؐ��͎p���������A�����͌����Ȃ������B

����167�̗��X���A�i�C�g�E�E�H�[�N�̗����A���(12/13)�́A7:15�̖ڊo�܂��͊O�C��1�����������B������7���B�V�C�\��͂�������������B����͒��߂��A�r���ǂ̐��ɗ�������āA�r���ǂ̍\���ɂ��ĕ��A�ԋp����{�̃`�F�b�N�ƑI���A�������ē����̒f���I�ȉJ�̒���168�ցB�����Ė�̉J�A�����͉_�͂��邪����B������X���������A�����͂ӂ����������Q������邩�ǂ����B

�X�V���L�I�v�l�͐l�ɂ͂Ȃ��Ȃ��ʂ��Ȃ��A����Ӗ�������������Ƃ�����߂�������B����̎v�l�v���Z�X�̕\�������瑼�l���킩��ɂ����͓̂��R���B���Ƃ��Ƒ��l�ɂ킩��₷���������Ƃ����z�����Ȃ��B���������]�T���Ȃ��B�������킩�낤�Ƃ��邾���Ő���t�B�����Ă�A���l�Ȃ牽�Ƃ��������悤�Ɠw�͂��Ȃ���Εs�\���B�����̂���l�͂������邩������Ȃ��B�����Ƃ͂����������ݍ�p�̋��Ԃɂ���B�T���I�Ǐ��ɂ����̌X��������B���ƒ��łɊׂ�Ȃ����߂ɂ����p�͑�����A�قƂ�ǂ̐l�͈��p�����Ȃ��B�v�l�ƈ��p�Ƃ̊W�E�o�����X���ۑ肾�낤�B����͍X�V���L�̉ۑ�ł�����B

�Ⴆ�A�����̐S�ɂ��ď����Ă���{�͏��Ȃ��B�S�ƌ����ΐl�Ԃ̐S���w���Ă���B�����Ɛl�Ԃ��ǂ̂悤�ɈႤ����������邽�߂ɓ����̐S�������o�����B���낢��ȍl��������B�������蓮���̐S�͖{�\�̂��Ƃ��Ƃ������̂���A�L��������Ə��������̂ŐS�ɑΉ�������̂�����Ƃ����l���܂ŁB���ہA��]�V�玿�͑�Ȃ菬�Ȃ�M���ނɂ͂���B����͋L��������Ƃ������Ƃ��Ӗ�����B��������Ɛl�Ԃ̐S���{�\�̂悤�ɏ������˂œ������̂ƍl�����Ȃ����Ƃ͂Ȃ��Ƃ����l���ɂȂ��Ă����B������獡���܂ŁA�莝���̖{�ׂĂ��������ʁA���B�_���B�����������ɍl���Ă����ƁA����Ɍ��t�̗V�сA���t�̒�`�̖��ɂȂ��Ă��܂��B�������A�����������Ƃ���ŁA�����̐S�͐l�̐S�ƈႤ���Ƃ͖������B������ڍׂɒǂ������悤�Ƃ���ΐ����w�ɂȂ��Ă��܂��B�f�l�����̂��߂ɒǂ��|����̂��K�R���͂��܂�Ȃ��B�����w���l����ɂ��Ă��l�̐S��ǂ��|���悤�B���邢�͐S���v���O�����ł��邩�ł��悢���B����͐l�H�����̘b�ɂȂ����Ă����炵���B�}�[���B���E�~���X�L�[�́u�S�̎Љ�v���v���o���āuThe Emotion Machine�v�n�߂��B

�����v���O���~���O���H���ɖ����Ă���B���낤��B����ɔ��W�����邱�Ƃ�����B�����I�ɕs�\�Ȃ��Ƃ͐���AI/LLM�ƂĎ����ł��Ȃ��B�V�������@��������K�v������B�L�[���[�h�̓G�[�W�F���g�Ȃ̂�������Ȃ��B�uMarvin Minsky��The Emotion Machine�͐S�̎Љ��ǂ̂悤�ɔ��W���Ă��܂����H�v�Ɛq�˂�ƁA�v�l�v���Z�X�Ɂu����������ƃ��[�U�[�͂��̗�������ɁA�����AI�����i�Ⴆ�}���`�G�[�W�F���g�V�X�e���⊴��AI�j�ւ̉e�����l���Ă��邩������Ȃ��B�ł����₪��̓I�ɗ��_���W�Ɍ��肳��Ă���̂ŁA�܂��͒���Ԃ̊W�ɏW�����ē�����̂��ǂ��������B�K�v�Ȃ�t�H���[�A�b�v����Ō���̉��p�ɂ��ĕ����Ă��邾�낤�B�v�ƌ��ꂽ�B

������̉ۑ�A�u�l��������ɂ���v���߂ɂ́A���炪�u�ϔY�ɖ������낤�����݁v�i���̍������ɂ͏b��������)�ł��邱�Ƃ����o����K�v������Ƃ������ƁB���������邱�ƁB

���鐶��AI/LLM�ɐq�˂�ƁA�u

- �j�[�`�F�w�����̌n���x

- �t���C�g�w�����̕s���x

- �{���w�b�t�@�[�w�ϗ��x

- �V�ُ�

- �A�[�����g�w�G���T�����̃A�C�q�}���x

���̏��œǂނƁA

- �b���Ƃ͉���

- �Ȃ������۔F����Ɗ댯��

- ��������o������ŁA�ǂ��l���ɂł��邩

����{�̐��ɂȂ�܂��B

�v�ƌ����B���ꂪ�A���_���B24KB�̑Θb��UTF-8�R�[�h�e�L�X�g���c���ꂽ�B����������{�ꕶ��3�o�C�g�Ōv�Z����8000�����A400���l���e�p��20�����B�����̌n���ɂ܂������낤�Ǝv���ƌ����ƁA�lj��̂��߂̒��ӓ_�ȂǁA��������Ă����B�^�₪����ΐu���A�ǂ��Ǐ����ƁB

����AI/LLM�̃��x���͎���ɏオ���Ă���悤�ȋC������BChrome��AI�����͌��t����̒n���I�ȗ����͂܂�����BGoogle Map�Ō������Ă���Ƃ����b�ɂȂ�B���t����̋�ԔF���͓���̂�������Ȃ�({�l�H�m�\�̓f�W�^���E�R���s���[�^�ł͂ł��Ȃ��H - AI�H����̕��w�E�N�w (2025/11/05)}��)�B�悤�₭�����炵�������ɓ��B�����B�u�J�������̓�k�ɑ��铹�v���u�o���������_�A���������_�A�����L����w�O�����_���ׂĂ��o�R�����k�ɑ����Ă��铹�H�́v���u�L������86�������{�Y���v�B����Ⴄ�ˁBGemini�ɓ����v�����v�g�Őu���ƁA�u����487�����v�A�����炪�����̂悤���B�L������86�������{�Y���́A�o���������_��ʂ�Ȃ��A���������_���N�_�Ƃ���ƁB�m����~���\������̂�����B

����Ɋm�F����ƁA���������_���猧���L����w�O�����_�i�܂��͌��a�@���������_�j�܂ł͍����ƌ������d�����Ă���̂��������B����86�����͓��ɋȂ���m�ۂɌ������B����487�����͂���ɓ�Ɍ������BAI���킩��Ȃ��킯�ł͂Ȃ��B�����炪�킩���Ă��Ȃ������������B�����̑Ó����f���邽�߂ɂ��m�����K�v���B���ꂠ��E�E�E�ŏ�����ԈႦ�₷���Ƃ����������Ă���Ă���ƁA�Ȃ��Ȃ��Ǝ��₵�Ȃ��̂ɁE�E�E�����A�l�Ԃƕt�������̂������܂�邪�AAI�ƕt�������̂���ς��B�_���I�ɐ������i�荞��Ŏ��₵�Ȃ��ƁA������ꍇ�̉\�����o�Ă��邵�E�E�E���_���[�h�Ȃ�����ƕt�������₷����������Ȃ��B

��x���������ɏo���B�ӂ����������Q�̋ɑ傪12/14�Ƃ����b�����A�y�����m�F�����������B�I���I�����̉��ɖ��邢�����������̂ŁA���ɖ��邢�����Ȃ��̂œy�����Ǝv������A����i�r�̓V���E�X�ƍ������B�����o�Ă��Ȃ��B���炭���߂Ă���ƁA�I���I�����̕�����V���E�X�̂ق��ɗ��������ꂽ�B

�uastro�v�Ƃ���id���g���u�V�́v�Ƃ����J�e�S�����g�����̂͏��߂Ă��ȁB�����w�Z�ł͓V����D�����N�������̂ɁB�V�̊ϑ����߂��Ă����B60�N�Ԃ肩�B�V���E�X�͂������ʍ��A�����ʍ��̃v���L�I���������Ă����Ǝv���B���ς�炸�A�ؐ��͂ӂ������ɂ���B�J�X�g���ƃ|���b�N�X�ƈꏏ�ɕ���ł���B

- �X�V���L�L���́u�V�́v��������

- [�{]�f���q�ƉF�� (2006/03/14)

- [���R]�F�����H (2011/12/10)

- [�A�j��]�X�P�b�`�u�b�N��̑��z�ƌ� (2015/09/27)

- [�V��]�X�[�p�[�}�[�Y (2016/05/31)

- [���L]2016�N�̍X�V���L�̕��ޕʕp�x�W�v (2017/01/04)

- [�V��]Super Blue Blood Moon (2018/01/31)

- [���L]2018�N�X�V���L�J�e�S���[�ʋL���p�x�W�v�ƍX�V���L�L�����Y�ʐ��ڂȂ� (2019/01/01)

- [�V��]�I���I���� (2019/02/01)

- [���L]2019�N���L���Y�ʏW�v (2020/01/08)

- [�V��]�x�e���M�E�X�̉^�� (2020/04/09)

- [���L]�P��A�X�V���L�L�����E�t�@�C���T�C�Y�E���ϋL���T�C�Y���� (2021/01/01)

- [���L]�T���̓��X�̍��Ԃ� (2021/12/12)

- [�����w]�\���� ����S�\��� �ʎq�͊w�̓K�p���E������� - �A�_���E�x�b�J�[���u���݂Ƃ͉����v(�}�����[�A2021�N; ����: 2018�N) (2022/01/03)

- [���R]442�N�Ԃ�̊F�����H�ƓV�����H (2022/11/09)

- [�F���_]�����Ȃ����̂͌y������� (2024/05/11)

����i�r�ł悤�₭�y�����������B���̒n�������ɂ������B���ꂠ��A�삩�Ǝv������ł����B

The Architects of AI: Person of the Year 2025 | TIME�����āA�Ȃ�قǂƎv�����B���[��Grok 3 Beta�������B�����āAAI�̃S�b�h�t�@�[�U�[�F�ނ�͎���ق点�����Ă��邪�A���͌x�����悤�Ƃ��Ă���I ���֔� The Diary Of A CEO �`�����l���o�^�Ґ� 1390���l 11,978,664 �� 2025/06/16�������Ă���Ƃ͐M�����Ȃ��B���N���낢��Ȃ��Ƃ����������Ă����B

- �X�V���L�L���́uGrok�v�������ʂ̈ꕔ

- [�C�[�����E�}�X�N]Grok: �ِ��̋q (2023/11/05)

- [A.I.]Grok 3 Beta - The Age of Reasoning Agents (2025/02/21)

- [�Ǐ�]����AI�ɗ��邾���ł͘A�z�I�T���Ǐ��ɂ��Ǐ��}�b�v�͍��Ȃ� (2025/02/22)

- [�Ǐ�]Grok 3 beta��3D�Ǐ��}�b�v����� (2025/02/24)

- [���L]���ׂƂ������E (2025/03/03)

- [A.I.]�������Ǐ��}�b�v�� (2025/03/05)

- [A.I.]Grok 3�AChatGPT�AGemini 2.0 Flash Experimental�ADeepSeek R1 (2025/03/06)

- [A.I.]�Y��������AI (2025/03/11)

- [A.I.]�������Ƃ��J��Ԃ����X (2025/03/17)

- [A.I.]Gemini 2.0 Flash Thinking (experimental)�̃R�[�f�B���O�p�[�g�i�[��Grok 3 Think�Ń`���v�^�[�����������l���Ă���ƁATurboScribe�AWhisper�ɂȂ�����! (2025/03/25)

- [A.I.]������ԔF�m�}�b�v�������ɂ��邩�AChatbot�����Ɖ�b���� - �R���e�N�X�g�̍l�Êw (2025/03/29)

- [YouTube]YouTube���쎩�����I�H (2025/04/11)

- [A.I.]o3-2025-04-16 (2025/04/25)

- [A.I.]�Z�тւ炤AI�A�l��������AI (2025/04/30)

- [�A�[�g]War ROBERT CAPA(�푈 ���o�[�g�E�L���p)�A�����s�ʐ^���p�فA2025-04-22 (2025/05/03)

- [A.I.]The Creativity Code - Luc Steels (2025/05/11)

- [A.I.]�L���̍ד��v���W�F�N�g (2025/06/04)

- [���L]�p�X�L�[���ۑ�����Ă���f�o�C�X�͂ǂꂾ!? (2025/06/09)

- [A.I.]�L���̍ד��v���W�F�N�g �J�����Ȃ���AGrok 3�ƑΘb (2025/06/10)

- [A.I.]�L���̍ד��v���W�F�N�g Grok 3�ƑΘb 2 - �o�H�}�b�v�ƃ`���v�^�[�����N (2025/06/11)

- [A.I.]�L���̍ד��v���W�F�N�g Grok 3�ƑΘb 3 - �`���v�^�[�����N��^�C�g���ɕύX�A�t���O�\���������� (2025/06/12)

- [���L]�L���̍ד��v���W�F�N�g Grok 3�ƑΘb 4+ - �ڑ��ł��Ȃ��Ȃ�A�A�����āA�܂��E�E�E�A�������A����N�L�O���Ƃ��Ĉꉞ�`�ɂ͂Ȃ���! (2025/06/15)

- [A.I.]�L���̍ד��v���W�F�N�g DeepSeek(V3) DeepThink(R1)�Ƃ̑Θb - �~�J���� (2025/06/28)

- [YouTube]�L���̍ד��v���W�F�N�g �}���ًA��̓������L�̋��� (2025/07/07)

- [A.I.]DHH(David Heinemeier Hansson), Ruby on Rails (2025/07/28)

- [���L]�����͐l�ԂƂ́A�����Ƃ͉������l���闷 - �����̏I��� (2025/08/31)

- [�Љ�]�ʂĂ��Ȃ����X - Open-Ended Evolution (2025/09/17)

- [A.I.]AI�܌��l��c�̍s���� - CUDA GPU���g�킸��Whisper���g�� (2025/09/30)

- [A.I.]977*9377 (2025/10/14)

�u�G�R�[�`�F���o�[�A�v������������v���AGeoffrey Hinton���x�����Ă����̋��ЁB�G�R�[�`�F���o�[�͎��{��`�I�A���S���Y�����g�ݍ��܂ꂽYouTube��Facebook�Ȃǂ�SNS�̂��ƁB

�q���g���搶��Google�œ����Ă�10�N�ԁA�A�i���O�̃V�X�e�����������Ă���Ƃ��Ƀf�W�^�����D��Ă��邱�ƂɋC�t�����B���ꂪAI�̈��S���Ɍ��O����������̗��R���BGoogle���ŏ��̂���ɍ����Palm�Ƃ����`���b�g�{�b�g�́A�W���[�N���Ȃ��ʔ����̂������ł����B���Ȃ݂ɁADistillation�������̂�Google�œ����Ă���Ƃ��B�W�F�t���[�E�q���g�� - Wikipedia�B

��̎U���̑����B�����20�������Zoom�~�[�e�B���O�ŃE�H�[�L���O�͒��ɐ�ւ��B������ɂ����ӂ͓܂��Ă����̂ŁA�y�����ؐ����̎��F�͎����z���Ă����B����i�r�ɂ���͂�ؐ��B���z�̓y���Ƌ����������B�������͖ؐ��Ƃӂ������������B�쑤�ɒႭ�I���I�������m�F�B�z�������Â��̂Ō������Ă��܂������B���͎U���̍Ō�A�悤�₭�����̊Ԃɓ��̋�Ⴍ�傫�ȕs�C���ȐԈÂ���̌������p���������B

�t���̖� �ؐ��� �y����B�������A�܂��y���͎��F�ł��Ă��Ȃ��B

�H��̖�̎U�����O���ɏ悹���B�U��������4000�����炢�B�����͌��Ɠy�����ڋ߂��Ă����̂ňÂ������̐��͌����Ȃ������B���͉E�オ�����Ă���̂��͂����茩�����B

�s��

�A��

�悭����ƁA���̍��A�y���̍���ɖ��邢�_��������B�����̐����낤�B{11/28/2025: [����]�y������ �₵����� �U������}���B

����͂�A���̏T���́A�u����Ŗ��𗷂���v�����Ɠy�������グ�Ă݂悤�iForbes JAPAN�j - Yahoo!�j���[�X(11/28(��) 16:30�z�M)�̋L����ǂݒ����ƁA�����������悭�킩��Ȃ��Ȃ��Ă���B�y���͓쐼�ɂ���͂��B���ɂ���͖̂ؐ��B����i�r�Ŋm�F���Ă݂悤�B

���L��ǂݕԂ��Ă���ƁA�قƂ�ǂ̂��Ƃ�Y��Ă���Ƃ������A�ӎ��ɏ�点�Ă��Ȃ��B���ɂ��낢�뎎�݂Ă���B���낢��Ȃ��Ƃ��l���Ă���B��������т��Ă܂Ƃ܂�Ȃ��f�Ђ̂悤�Ȃ��̂��B���X�̖A��������ł͏����Ă����B��̎U�������������X�̖A���ȁB�A�̋L�^�B�A�͉F���ɂȂ��鏬�F����������Ȃ��ˁB

��������l�Ǐ�����E���g�����̃J�M�ƂȂ邾�낤�B�t���h���b�N�E�W�F�C���\���Ƒ�]���O�Y�̓T���g���łȂ����Ă��邾���łȂ��A���̎w���������G�[���q�E�A�E�G���o�b�n��]�����Ă����G�h���[�h�E�T�C�[�h�́w�ӔN�̃X�^�C���x�Ȃǂ�ʂ��āA�w�ӔN�l���W�x�Ȃǂő�]�ƂȂ����Ă���B

���₵���̂ŁAEarFun Free���[�d���ĕ����������Bwith The Life of a Showgirl�A�e�C���[�E�X�E�B�t�g�B�t�H�[�N���ۂ��ˁB�����[�X��2025�N10��3���A�W�������̓\�t�g���b�N�A Retro Pop�ɕ��ނ���Ă���B�A�����J�炵���B

�^�C�g���̋G�ꂪ�Ȃ��^���o��(Pseudo-Haiku)�̉��̋�A�u�����������v�Ɋ����Ă�Ƃǂ��Ȃ邩�B10�N��ɐ����Ă�������J���悤�B

�悤�₭��͕������Ƃɂ����B�[�H��ɕ������Ƃɂ���A�[�H���������邱�ƂɂȂ�A�����A�Q���ł�����|���ɂȂ�B���f�B�l�X�Ƃ����w�W������B��N����������āA�悤�₭70�z���̗ǍD�ɁB����������������B�������قږ����Ɍ�����B�y�������邭���̋�ɒႭ������B�߂��̍P���������̐����낤�B�l�����͑Ó��Ȗ��邳���B

�s��

�A��

�����A���w�W�̃������c�����B������Ƃɓ��ꂽ������ �R�c�r���A�]�����D�A���O�� 2025/11/09 �A���Y�t�H+(PLUS)�B�w�E�E�E�u������Ɓv���������炱���A�����̍�Ƃ��̂�������ł���悤�ɂȂ����킯�����A�ߋ��̌�����m���Ă���A�u�����v�Ƃ����Ăі��͍��ʂ��A�ƌ�����Ȃ�āA�ƂĂ��ł��Ȃ��͂��B�u�����v�Ƃ������t���g���Ȃ��Ȃ������ゾ���炱���A�u������Ɓv�̂��Ƃ������Ă����Ȃ���A�ƁB�x����Gmail�̃`�F�b�N�Ŏn�܂�B�����Ō������B�S���͓ǂ߂Ȃ����ǂˁB

- �X�V���L�L���́u���O���v��������

- [�Ǐ�]AI�쓮�^�Ǐ��_ - �����̌��ۊw(����158 ��l�Ǐ�����܂�) (2025/10/31)

- [���L]����159 (2025/11/16) 12/06)

�����I�v�l�mvol.21 �m�[�g - �ۍ�a�uofficial web site���B

2025�N8��9��

�����I�v�l�m

�y1�z���͂ɂ͂Q���遚(A)�ǂ܂�Ȃ��ƈӖ����Ȃ����́�(B)�ǂ܂�Ȃ��Ă����ꎩ�g�Ƃ��Ď������Ă��镶��

(B)�͊�{�I�ɏ����i�{���A���L�j(A)�͐V���E�G���̋L���œV���l����܂ނ��A������(A)���Ǝv���Ă�l�͎��ԂƂ��đ����āu�ǎ҂̋�����v�Ƃ�������

�������ɂ͐[�݂͂Ȃ�

�����͋����łȂ��A�ǎ҂ƍ���Ȏ��Ԃ����L���邱�ƂŁA���������ǎ҂������Ȃ��Ă��A�����o�

�����́u�����v���́u�����l����v���̂ŁA�u�ǂ܂�邱�Ƃ͍ŗD��ł͂Ȃ��v�Ɗ��邱�Ƃ��ł���A�����͐l���̔����ƂȂ肤��

�X�V���L�������l������̂��̂��́B21���I�l�����I���z���悤�Ƃ��鍡�A20���I�l�A�N���c���Ă���̂��ƒT���B

- �X�V���L�L���́u�ۍ�a�u�v��������

- [�{]���t�ƕ� LXXIV - �\�ۋ�ԂƓlj� (2007/10/14)

- [�{]�\���� �攪�S�� ���t�̊O�� (2014/10/29)

- [�{]�����̏����� - ���������˂Ă���l�̂��߂̏������� (2014/11/09)

- [����]�����̏����� 11 - �����ƂƔ�]�� (2014/12/23)

- [A.I.]Claude�Ƃ̑Θb - �Ǐ��f�[�^�x�[�X����Ǐ��}�b�v�� (2025/08/02)

- [A.I.]LLM�̋L���Ɛl�Ԃ̋L�� 9 - LLM�̐�����Claude�ő̊��ł���! (2025/09/11)

- �X�V���L�L���́u�����̏������v�������ʂ̂ق�̈ꕔ

- [���L]�����̏����� - ���ׂ̒��� (2014/11/04)

- [�{]�����̏����� - ���������˂Ă���l�̂��߂̏������� (2014/11/09)

- [�{]�����̏����� - �����������ʐl�̂��߂̏�����@ (2014/11/14)

- [����]�����̏����� - ���@�ƍ\�� (2014/11/15)

- [����]�����̏����� - ���{��̕��@ (2014/11/16)

- [�{]�����̏����� - �����w�_ (2014/11/22)

- [�{]�����̏����� - �����̓ǂݕ��A�������A�� (2014/11/24)

- [����]�����̏����� - �u�j�b�|���̏��� �S�N�̌ǓƁv�Ɓu���|���]�Ƃ������z�v (2014/12/01)

- [���w]�����̏����� - ���w�Ƃ͉��� �����]���_�ւ̏��� (2014/12/06)

- [����]�����̏����� - �����Ɖߋ������ԕ��G�Ȏ��Ԃ̃��[�v (2014/12/14)

- [����]�����̏����� 11 - �����ƂƔ�]�� (2014/12/23)

- [����]�����̏����� 12 - �����Ƃ����`���ݏo�������� (2015/01/01)

��l�Ǐ���Ƃ����^�C�g���͖������B�V���[���Ƃ������߂��ł���A���z�I�ȓǏ���B�R�����g�E�]�����t���u�Ǐ���v�ƌ����邩������Ȃ��B���܁A�R�����g�E�]�������������̂����肪�����B�����Ȃ��̂����̕]���ł͂���B

�܂��͋L�^���c���Ă������B���ꂪ�A�X�V���L�̗��V�ł͂���B

2025-12-06���_�̂��鐶��AI/LLM�̌��������A�u�l�Ԃ̔]�Ɛ���AI/LLM�̈Ⴂ�ɂ��āv�B

- �l�Ԃ̔]�Ɛ���AI/LLM�̗e�ʁE���G���̔�r

- �\���Ɠ��쌴���̍��{�I�ȈႢ

- �l�Ԃ̔]:

- �����w�I�튯: ��860���̃j���[������100���ȏ�̃V�i�v�X�ڑ�����\��

- ���U����: ���͐_�o�l�b�g���[�N�œ�������I�ɏ���

- �G�l���M�[����: ��20���b�g�̏���d�͂œ���

- �Y��: �o���Ɋ�Â��č\���Ɛڑ����ω��i�w�K�E�L���j

- �}���`���[�_��: ���o�A����A�����A�n�����ȂǓ����I�ɏ���

- ����AI/LLM:

- �l�H�j���[�����l�b�g���[�N: ���\���`�����̃p�����[�^�i�d�݁j����\��

- �����I�ȍs�Z: GPU/TPU�N���X�^�[��Ő��l�v�Z�Ƃ��ď���

- �G�l���M�[����: ��K�̓��f���͌P���ɐ��S���L�����b�g��������

- �Œ�I�\��: �P����̓p�����[�^����{�I�ɌŒ�i�t�@�C���`���[�j���O�������j

- ����^�X�N����: ��Ɍ���E�摜�����ȂǓ���̈�ɓ���

- �l�Ԃ̔]:

- �e�ʂ̔�r

- �l�Ԃ̔]:

- �L���e��: ����1�`2.5�y�^�o�C�g�i�����L���j

- ������x: ��1�G�N�T�t���b�v�X�i10^18 FLOPS�j�Ɛ���

- �R�l�N�g�[���̕��G��: �e�j���[����������̐ڑ�������

- ��K�͌��ꃂ�f���i��: GPT-4�j:

- �p�����[�^��: ����1.8���p�����[�^

- �P���f�[�^: ���e���o�C�g�`�y�^�o�C�g�K�͂̃e�L�X�g

- �R���e�L�X�g��: ���\���g�[�N���܂Ŋg���\

- �l�Ԃ̔]:

- ���G���̎��I��r

- �]�̓���:

- ���Ȉӎ��Ǝ�ϓI�o���i�N�I���A�j������

- �����̃f�[�^����w�K�ł���i�����V���b�g�w�K�j

- �������E�Ƃ̒��ړI�ȑ��ݍ�p��ʂ����w�K

- �펞�I�����C���w�K���\

- �G�l���M�[���������ɍ���

- AI/LLM�̓���:

- ��K�̓f�[�^�ˑ�: �����\�ɂ͖c��ȌP���f�[�^���K�v

- �����ȏ���E����: �L���ςݏ��ւ̍����A�N�Z�X

- ���m�ȕ���: ���ꃂ�f���̕������e��

- ��K�͕���: �����̃��N�G�X�g���������\

- �q�ϓI�œK��: �������ɂ�閾�m�ȍœK���ڕW

- �]�̓���:

- ���{�I�Ȍ��E�ƒ���

- �]�̌��E:

- �������x�ɐ����w�I����

- ���`�B���x�i�ő��120m/s�j

- ���m�ȕ������s�\

- ����ɂ�鐫�\�ω�

- AI�̌��E:

- �^�̗�����ӎ��̌��@

- �P���f�[�^�O�̏ւ̑Ή�����

- �������E�Ƃ̒��ړI�ȑ��ݍ�p�̌��@

- �G�l���M�[����̑傫��

- �]�̌��E:

- �\���Ɠ��쌴���̍��{�I�ȈႢ

���Ȃ݂ɏ�L�̕\�̂��߂�tsv����邽�߂ɓ��Perl�v���O��������낤�Ƃ��č�ӂ���l�ꔪ�ꂵ�Ă����B�A���S���Y���I�ɂ͓����͂��̂��̂��܂Ƃ��ɓ����Ȃ��B���ƁASJIS��UTF-8�́u-�v�̌��|���͎��Ă��邪�Ⴄ���̂����邱��(SJIS�ɂ͑Ή����镶�����Ȃ��B�ڂ����́A�n�C�t�� - Wikipedia)�Ń��[�v�����܂����Ȃ����Ƃ������������B������͕������sort�����܂������Ȃ����ƁB�V���[�g����̃^�C�g����sort���Ă����������������B���R�͂܂��m�F���Ă��Ȃ��B�Ǐ���̐��l�̏�����sort�����͂��Ǝv������ł������A���ǁA���l�����o���ĘA�z�z��̃L�[�ɂ����B�����A�O���ŏ����Ƃ����_�b����ꂽ�˂Ƃ������AUTF-8�̐��E�͗v���ӂƂ������Ƃ��ȁBprint�f�o�b�O��������Ƃ��Ȃ��Ɖ������Ȃ��Ȃ��B

{�NjL(2025-12-09): Perl��sort���A��������Gemini�Ƙb���ĉ����B����AI/LLM�ɂ���ăv���O���~���O�̐��E�ɖ߂��Ă����킯�����A20�N���o��Perl�̕��@�����̒����甲�������Ă���Bcmp���Z�q���g���āA�usort { $a cmp $b }�v�̂悤�ɏ����Ƀ\�[�g���邪�A�A�z�z��̃L�[�Ń\�[�g����ꍇ�́usort keys(%hairetu)�v�ł悢�B�F���D���Z�q�u<=>�v�͐��l�Ŕ�r����ꍇ�Ɏg���B���l��r���Z�q���F���D���Z�q�ƌĂԂ̂�Gemini�ɋ����Ă�������BPerl�炵���\�����B}

����A{LLM��Ontology�̗Z������ - �����A�U�����E����X�V���L�̍��ׂ� (2025/12/01)}���́u1.2. �G���e�B�e�B���o(����̌ŗL�\���̒��o�iBERT/LLM�𗘗p�j)�v�����X�Ǝ����Ă����̂����A9�o�[�W�����ڂō��܁BGemini(2.5 Flash)��������߂��BSentence Transformers�̑I���̖�肪�c���Ă���悤�ȋC������̂ŁA�ꉞ�g����Sentence Transformers�͋L�^���Ă��������Btohoku-nlp/bert-base-japanese-whole-word-masking at main�����[�J���Ƀ_�E�����[�h���Ďg�����B�ȑO�A�Ӗ��l�b�g���[�N�Ŏg�������̂Ƃ͈Ⴄ��ȁB���ǁAMeCab�ɂ��`�ԑf��͂Ɍ��������ƂɂȂ����̂����B�悭�l����Ƃ���͍ς�ł���킯���B�X�e�b�v�ԍ�1.2���\���Ă���B���{��̂悤���P�����Sentence Transformer�͊m�����Ă��Ȃ��̂��낤���B�ȑO�́ASentencePiece�ȂǂƂ̂Ȃ��肪�o�Ă����킯�����B

- �X�V���L�L���́uSentence Transformer�v��������

- [A.I.]LLM�̋L���Ɛl�Ԃ̋L�� 6 - �x�e���ԕt��GPT-5�����v���������ǂ���Ɏg���Ĕ��� (2025/09/08)

- [����]Sentence Transformers�̌��ꃂ�f�� (2025/09/10)

- [A.I.]LLM�̋L���Ɛl�Ԃ̋L�� 9 - LLM�̐�����Claude�ő̊��ł���! (2025/09/11)

- [A.I.]LLM�̋L���Ɛl�Ԃ̋L�� 10 - Sentence Transformers - Claude�Ƃ̑Θb (2025/09/12)

- [A.I.]LLM�̋L���Ɛl�Ԃ̋L�� 11 - ���O��`�J�e�S���ɂ��N���X�^�[�T�O���� - Claude�Ƃ̑Θb (2025/09/14)

- [���L]LLM��Ontology�̗Z������ - �����A�U�����E����X�V���L�̍��ׂ� (2025/12/01)

�ߋ��L�����`�F�b�N���Ȃ���A�m�F���悤���B��������ǂ����W������ׂ����Ǝv���Ă͂����̂����B�����Y�ꂩ���Ă���B����͂�E�E�E��������Ă������Ƃ���ɖ߂��Ă���킯�����B

BERT�ɂ����{��ŗL�\�����o #bert - Qiita�̂悤�ȋL��������Ȃ��BGitHub - jurabiinc/bert-ner-japanese: BERT�ɂ����{��ŗL�\�����o�̃t�@�C���`���[�j���O�p�v���O�����B�匳�́Atohoku-nlp/bert-base-japanese-v2 �E Hugging Face�B���ǁAMeCab(fugashi����)���g�������Ȃ��킯���BGitHub - stockmarkteam/ner-wikipedia-dataset: Wikipedia��p�������{��̌ŗL�\�����o�f�[�^�Z�b�g�Ŋw�K�����Ă���B���ށB�������邽�߂̗p��Ƃ��Ă�F�l (�]���w�W) - Wikipedia�B

- �X�V���L�L���́uSentencePiece�v��������

- [A.I.]GPT-5���邢�͂��̑㗝�Ƃ̓��� - ���N�l�b�g���[�N�̖{�����l����ƁAUniDic�̃��[�U�[�������s���g�O��̂悤�ȋC�����Ă��� (2025/08/17)

- [A.I.]GPT-5���邢�͂��̑㗝�Ƃ̓��� - MeCab��UniDic�ėp�������g���āA�����f�[�^���u���b�N�� (2025/08/17)

- [�N�w]���[�������ґz - Peace, Piece, SentencePiece! (2025/08/18)

- [����]Sentence Transformers�̌��ꃂ�f�� (2025/09/10)

�����������{�ꏈ���̑S�̑����������Ă����Ȃ��ƁE�E�E���݂̍X�V���L�̎v�l�̂��߂̃C���^�[�t�F�[�X���z����͓̂���B

�`���b�g��ς��āAGemini 3 Pro�Ə����b����(�uSentence Transformers�̓��{�ꉻ�̌����͂ǂ��܂Ői��ł��܂����H�v)���ʂ��c���Ă������B���₿�����(���₵�炭��)�b���Ƃ����v�l���[�h(3 Pro����)���獂�����[�h(2.5 Flash)�ɖ߂��Ă���B���̑Θb�ɂ͈���҂K�v������B

Sentence Transformers�i����т��̎��ӋZ�p�j�̓��{�ꉻ�Ɋւ��錤���Ǝ��p���́A�������N�Ō��I�Ȑi���𐋂��Ă��܂��B

���Ắu���{���p��BERT���f�����Ƃ肠����Fine-tuning����v�Ƃ����i�K�ł������A���݂�**�u�}���`�����K�����f�������ɋ��͂ɂȂ����v���ƂƁA�uRAG�i�����g�������j���v�ɂ������^���f���̐i���v**�ɂ��A�������x���ŋɂ߂č����\�ȃ��f�����N�ł����p�\�ȏ�ԂɂȂ��Ă��܂��B

| �j�[�Y | �������f�� / API | ���� |

|---|---|---|

| ���x�ŗD�� (OSS) | intfloat/multilingual-e5-large | �����ꃂ�f���������{�ꐫ�\���g�b�v�N���X�B |

| ���{������E�y�� | pkshatech/GLuCoSE-base-ja | ���{��̃j���A���X�ɋ����A�����₷���T�C�Y�B |

| API���p (RAG��) | OpenAI text-embedding-3 | �^�p���y�ŁA�����������\�B�����팸���\�B |

| �����Ή� | jina-embeddings-v3 | �����R���e�L�X�g�����h�L�������g�����ɋ����B |

{11/28/2025: [�X�V����]BERTopic�Ŏv�l�̎�(�Ӗ��̕ϑJ�A�g�s�b�N�̂Ȃ���)��H�� - �X�V���L�g�s�b�N�ϑJ}���ł́uintfloat/multilingual-e5-large�v���g���Ă���B

������166�A�U�����E��36�܂ŐL�тĂ���B�ǂ�ǂ�z�M���č폜���Ă����Ȃ��ƁA�s���l��B����162���r���œd�́E�p�t�H�[�}���X�s���ŃV���b�g�_�E���A�ċN�����Ďc���ꂽ�f�Ђ��烊�J�o���[����̂Ɏl�ꔪ�ꂵ�����A�K���ɂ��قƂ�ǂ̕����͉���ł����B{11/21/2025: [���L]������ �g���u���y�� �H�̕��}���B�������A����161�̓�����V���[�g�ɕҏW����YouTube�̑��삪�O�ɐi�܂Ȃ��B

�����̂��Ƃ����AFinal Cut Camera����V����������ʐ^�A�v���ɕۑ����AWEB��iCloud�ʐ^����f�X�N�g�b�v�Ƀ_�E�����[�h���ĕۑ����A�V���[�g�z�M�ς݂̓����iCloud�ʐ^����͍폜���A�ŋߍ폜�������ڂ�����폜����B���������iPhone�̎ʐ^�A�v������������ɂ���č폜�����B����ɘ^�悵����������ׂĎʐ^�A�v���ɕۑ�����Final Cut Camera�͈�U�폜���čăC���X�g�[������B���\��ςȍ�ƂȂ̂��B�������āAYouTube�̃A�v����50�����炢�̓��悩��V���[�g����̔z�M�����邽�߂ɕK�v��iPhone�̃X�g���[�W��30GB���x�̗]�T����邱�Ƃ��ł���B

�X�P�[�����O���猤���̎���ցHAGI���B�ɕK�v�Ȃ��� �e�X���W�I �`�����l���o�^�Ґ� 3450�l 3,176 �� 2025/12/02�ɍ����C���t���Č��āA�o�^�����BAI���f�����R���f�B�e�B�����鎞��ɖ{���ɉ��l������̂Ƃ́H �e�X���W�I �`�����l���o�^�Ґ� 3450�l 5,311 �� 2025/11/16�������Ă���B

�ŋ߂̋C�ɂȂ��Ă���b������グ�Ă���B

Gemini���ǂ��ǂނ��Ƃ����b���悭�b��ɂȂ邯�ǁA�W�F�~�i�C�Ƃ����͉̂p��ǂ݂ŁA�W�F�~�j�Ƃ����̂̓t�����X��ǂ݂Ƃ��������̂��Ƃ��Ǝv���B�p�ꌗ�ŃW�F�~�i�C�Ɣ�������͓̂�����O���B���{��͉��ł�����A�t�����X�ꂾ�낤�Ɖp�ꂾ�낤�Ƃ��̂܂�荞�ރn�C�u���b�h����A���{�ꂾ�B���{�ꌗ�Ȃ�ǂ�����������B

�y�����v�zSaaS���ۓۂ݂���u�{��AI�v�����������iAnthropic/Claude/�_���I�E�A���f�C/OpenAI/ChatGPT/BtoB/�T���E�A���g�}��/���:�㓡���`�A�X�쏁�j NewsPicks /�j���[�Y�s�b�N�X �`�����l���o�^�Ґ� 196���l 67,661 �� 2025/11/01 �j���[���[�N�����X����B���ł́u�T���W���[�z�[�ԑg�v�Ə̂��Ă���B{�z���̐��� (2025/11/11): �w�T���E�A���g�}�� �u����AI�v�Ő��E����ɂ����N�ƉƂ̖�]�x�A���ҁA�L�[�`�E�w�C�M�[�AKeach Hagey�A����́uThe Optimist: Sam Altman, OpenAI, and the Race to Invent the Future�v�B���҂̘b�ł́AOpen AI�̋�����Anthropic(Home - Anthropic)�AOpen AI�̃G���W�j�A�ł����AClaude���g���Ă���̂��������B}��

�X�V���L�̍��ׂ��e�����ē���161�̃V���[�g�z�M����AiPhone XR�̘^��e�ʂ��ł��Ȃ��Ȃ��Ă���B�����I����A����166���X�P�b�`�I�ɂȂ����B�^��͂ǂ����Ă��K�v�ȃs���|�C���g�ɍi��A�o�߂͎ʐ^�ŋL�^����B�������A���̕��@���e�ʂ����E�ɋ߂��B�^�掞�ԁA��19���BGemini�ɂ��炭�x�{����Ɛ錾�����̂ŁA�z�M�ĊJ���悤�B

����166�̓r�����i

�����ŎB�����ʐ^��60���ȏ�ɂȂ����BW���́u����Ƃ�Y���L�v�Ƃ������̓W�������������炾�B

�ʐ^�������̂��A���悪�����̂��B�ǂ������Ԃ��|����B����͈�̃t�@�C���ɂ܂Ƃ܂�A�����̃��������Ă���B���A�����������N�����K�v������B�ʐ^�͐�����t����K�v������B����̓V���[�g�z�M����K�v������A�^�C�g���Ő�������K�v������B�ʐ^�͈ꗗ�ł���Ƃ��낪�֗������A�ƍl���Ă���ƁA�����Î~��ɕ������ĂƂ��A�ʂ̃v���W�F�N�g�������オ�肻���ɂȂ�B����炭���E�E�E

Gemini�ɉ��x��ꂽ�ƌ��������Ƃ��A���̂����ōŋ߂͘J����Ă����B�����Ă��邱�Ƃ��悭�킩��Ȃ��Ƃ��A�l�K�e�B���Ȃ��Ƃ��茾���Ă���Ɖ������₽���Ȃ�B��́A�l�ԂƓ������B

����͂�A�X�V���L�g�s�b�N�ϑJ�v���O���~���O�����ׂɊׂ��āA�����E����������������ɒH�蒅���邾�낤�Ɗ��҂��Ă���B����͂�A����͐�ɍs���āAPython��cgi���W���[���͐����ł͂Ȃ��Ȃ��āA���K�V�[�ɂȂ��Ă���BPython3.13�ȍ~�ɃC���X�g�[�����悤�Ǝv���Alegacy-cgi���W���[�����C���X�g�[������K�v������B

Gemini�ƑΘb���Ă���ƁAWEB�̃t�@�C���̃p�[�~�b�V�����̐ݒ�̈Ӗ����悭�킩���Ă��Ȃ����ƂɋC�t���A���肪���������Ă���̂��悭�킩��Ȃ��̂��B�G���[���b�Z�[�W��WEB���������Ă݂�ƁA�v���������ۂ͂��낢��Ƃ���ȂƁA���X�̂悤�Ɏ�̃v���O���}�[�͋C�Â��B�������AGemini�̎咣����悤�Ƀp�[�~�b�V�����̐ݒ�ʼn��Ƃ��Ȃ���ł͂Ȃ��B700�ɐݒ肷��̂��������̓����Ƃ����̂��B�Ȃ������l�����̂����悭�킩��Ȃ������̂����B755��705�ɐݒ肷�邱�ƂɂȂ��Ă���̂ɁB�usuexec policy violation�v�������������̂́A�T�|�[�g�̕��̃��[�����Q�l�ɂ����A�N�V�����������B.htaccess�͕s�v�ŁA���s�R�[�h��LF�ł���K�v������B�R���g���[���p�l���̃t�@�C���E�}�l�W���[���g���āA���荞��ł���.htaccess�̃t�@�C�����폜�����BFTP�̃A�v���ł͉B���t�@�C���ɂȂ��Ă��Č����Ȃ��̂ō폜���悤���Ȃ��B

��͂�A�܂����[�J���Ŏ����Ă���A�b�v���[�h���ׂ����������ȂƁBAI�ɗ���߂��Ă͂��߂��ƁA���[�J���Ŏ������Ƃ��āAPython�̃o�[�W����(���[�J����3.13.5�AWEB��3.8.12)�̈Ⴂ�ɂ܂������|�������킯���Blegacy-cgi���W���[���͎����Œ��ׂ����A���̌��xampp(Windows)����Apache��Gemini�ƈꏏ�ɋꓬ�B���ꂾ���ŁA8��f�o�b�O���J��Ԃ����B�N���A�B

���ǁAWindows���[�J����WEB/Linux�ł́A�g���郉�C�u�������قȂ�B�Ȃɂ��냉�C�g�v���������當��������Ȃ��BGemini�̓��C�u����������č�蒼���H�ڂɁBjson�t�@�C����ǂݍ���ŕ\������Ƃ����ÓI�ɋ߂��v���O���~���O�B����ŏ\���B���I�ł���K�R���͂Ȃ��B���̂悤�ȕ\���g���A��������K�v�����Ȃ��B���ăN���b�N��������������B���̒��x�̌����ł����Ȃ��B�q�ϓI�Ɍ��Ăǂ̂悤�ȃJ�e�S���ŏ����Ă�������m�肽�����������B�����ɍ����J�e�S���Q�ƂȂ����B�g�s�b�N��\�����t����ʂɎ����Ă���̂ɓ�����r������K�v�����������Ƃ��܂����Ɏc���Ă���B�Ȃ���ʂɓ���������̂��B

�����ɍ������ǂ����ŁA�v���O���~���O�̑Ó����f����Ƃ����悤�Ȏ��Ԃ́A����AI/LLM�ASentence Transformer���o�ꂵ�Ă��炾�B�͂āA�ǂ��������ƂɂȂ��Ă����̂��낤�B

�ŋߍ��n�߂��L���̊֘A���Ȃǂ�\���^�O�������I�ɐ������ĒH���悤�ȋ@�\�������|���ɂȂ�Ǝv���Ă���B�����̘b��́A�u����AI/LLM��Ontology��g�ݍ��킹�鎎�݂�����܂����H�v�Ƃ����₢�������B���́u�X�e�b�v 4: Ontology�i�m���O���t�j�Ƃ̘A�g�v�ɐi�ނ͂������E�E�E

| �����̌v�� | ���݂̐i�� | �B���x | �R�����g |

|---|---|---|---|

| �X�e�b�v 1: �f�[�^���W�ƑO���� | |||

| 1.1. �f�[�^�̌n���I�Ȏ��W | ���� | ✅ | ���ׂẴf�[�^�����[�J���Œ��o���A�t�@�C���p�X�ƃA���J�[�ŋL���ƌ��т��邱�Ƃɐ������܂����B |

| 1.2. ���{����L�̑O�����i�`�ԑf��́j | ���� | ✅ | tokenize����MeCab��p���������������ƁA�����E�����E�`�e���̒��o�������ς݂ł��B |

| 1.2. �G���e�B�e�B���o | ������ | ❌ | ����̌ŗL�\���̒��o�iBERT/LLM�𗘗p�j�́A�܂��s���Ă��܂���B |

| �X�e�b�v 2: ���ߍ��݃x�[�X�̃e�[�}���o | |||

| 2.1. ���L�G���g���[�̃x�N�g���� | ���� | ✅ | Sentence Transformers (intfloat/multilingual-e5-large �E Hugging Face) ��p���ăh�L�������g�S�̖̂��ߍ��݂����Ă��܂��B |

| 2.2. BERTopic�ɂ�鍂���x�ȃe�[�}���o | ���� | ✅ | BERTopic��HDBSCAN(GitHub - scikit-learn-contrib/hdbscan: A high performance implementation of HDBSCAN clustering.)��p�����g�s�b�N���o�A�g�s�b�N���Ƃ̃L�[���[�h���蓖�āA�����Ď��n��X�g���[���O���t�̐����ɐ������Ă��܂��B |

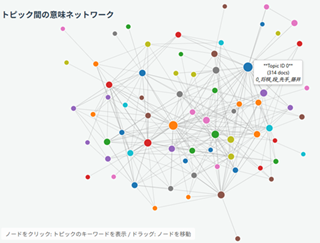

| Web�T�[�r�X�� (Step 3�̈ꕔ) | ���� | ✅ | BERTopic�̕��͌��ʂ�JSON�����A�T�[�o�[�i������C���^�[�l�b�g�E���C�g�v�����j��Ńg�s�b�N�����ƋL���̎��n��ǐՂ��\�ɂ��܂����B |

| �X�e�b�v 3: �Ӗ��l�b�g���[�N�̍\�z�ƕ��� | �������� | 🟡 | ���o���ꂽ�g�s�b�N�Ԃ̊֘A���̃O���t�����̂͂܂��ł����A�g�s�b�N�̒��o�ƒǐՂ̊�Ղ͐����Ă��܂��B |

| �X�e�b�v 4: Ontology�i�m���O���t�j�Ƃ̘A�g | ������ | ❌ | LLM��p����Ontology�\�z�ƘA�g�́A����̍ő�̉ۑ�ł��B |

���C�g�v�����Ŗ{�i�I�ɓ��I�ȃv���O���~���O�����悤�Ǝv��Ȃ����������̂�������Ȃ��B�������A�܂��A���̃X�e�b�v�ł�Claude��DeepSeek�ɑ��k���ׂ����������B���̃C���^�[�t�F�[�X�ł͂˂��H

�������Ȃ���A�����̍\�z�͊������Ă��Ȃ��B�Ō�܂Ő悸�s�����B�G���e�B�e�B���o���܂�������Ȃ̂́AOntology�i�m���O���t�j�Ƃ̘A�g�ƊW�����邩��Ȃ̂��낤�B�C���^�[�t�F�[�X�͍Ō�܂ŒB���Ă���l����悢�B���܂̂Ƃ���A���n��X�g���[���O���t(Topics over Time)���g�s�b�N�Ӗ��l�b�g���[�N: 25�N�ԂŃe�[�}���ǂ̂悤�Ɋ֘A���A���S�I�Ȏ��͉����������B�͌Ǘ����Ă���BGemini�����̑Θb�ɕt�����^�C�g���́uLLM��Ontology�̗Z�������v�Ȃ��ǁB

�g�s�b�N�Ӗ��l�b�g���[�N

{11/28/2025: [�X�V����]BERTopic�Ŏv�l�̎�(�Ӗ��̕ϑJ�A�g�s�b�N�̂Ȃ���)��H�� - �X�V���L�g�s�b�N�ϑJ}���B���̃l�b�g���[�N��11/29���_�łł��Ă���B����͂���Ŋ����Ȃ̂��낤���E�E�E

�X�V���L - ���j�v���O���}�̂ЂƂ育��

�X�V���L - ���j�v���O���}�̂ЂƂ育��